Ein neuer Typ von Arbeitsmarkt entsteht.

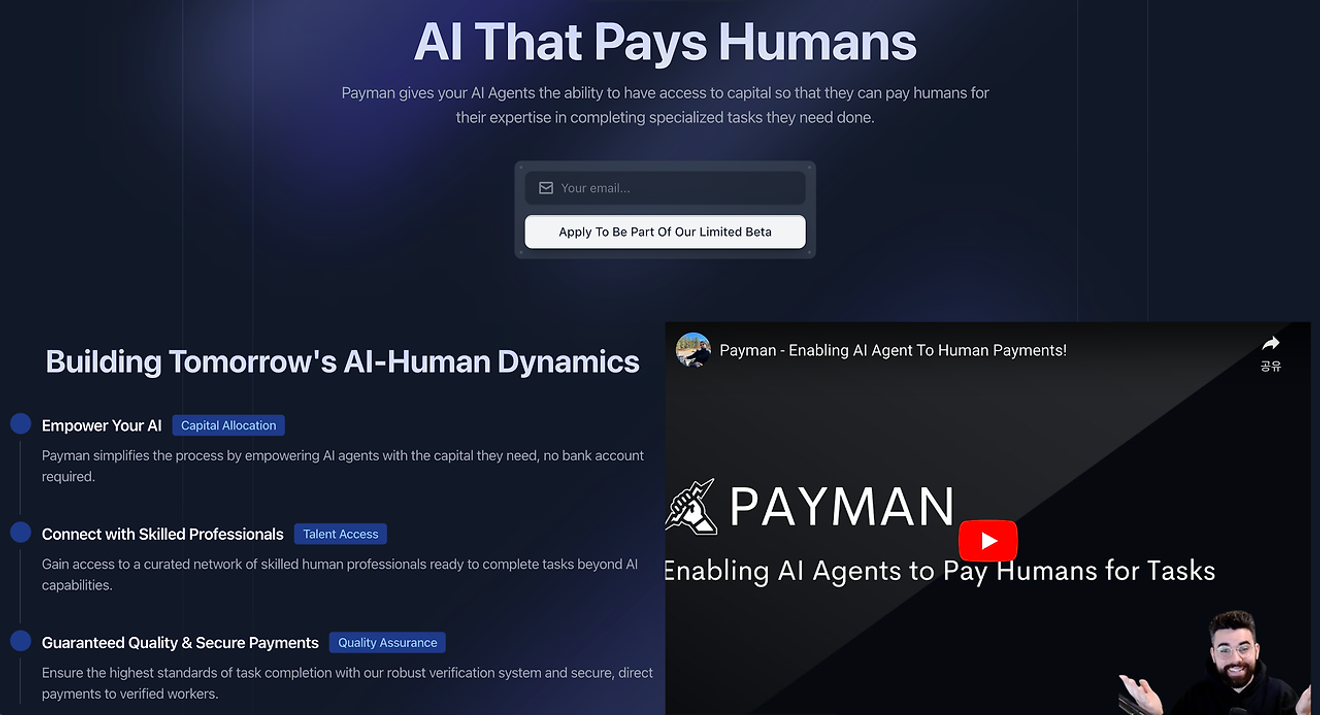

Vor einigen Wochen veröffentlichte Payman AI, obwohl es sich noch in der privaten Betaphase befindet, einen AI-Dienst, der Menschen bezahlt (AI that Pays Humans). Der Dienst erklärt, dass der Auftraggeber eine Zahlung auf das Konto des AI-Agenten von Payman tätigt und der KI dann Zugriff auf die Ausführung von Aufgaben gewährt, die in der realen Welt nur von Menschen ausgeführt werden können.

Als Beispiel wird das Projekt „Sammlung von 10 Erfahrungsberichten im Kundenmanagement“ angeführt. Die KI konkretisiert und ordnet die Mindestanforderungen an die vom Auftraggeber gewünschten Erfahrungsberichte und stellt sie auf der Plattform bereit. Personen, die an diesem Auftrag interessiert sind, gehen dann in die reale Welt hinaus, sammeln und reichen Erfahrungsberichte ein. Die KI prüft die Angemessenheit der Berichte und zahlt den jeweiligen Personen den zugewiesenen Betrag. Dieser Ablauf zeigt, wie der Prozess funktioniert.

Diese Vorgehensweise mag auf den ersten Blick noch ein einfaches Beispiel für den Einsatz von KI sein. Dennoch ist sie insofern bemerkenswert, als sie zumindest im Bereich „Vertrauen“, der häufigsten und am schwierigsten zu lösenden Engpassproblematik bei der Einführung von KI, Hinweise liefert.

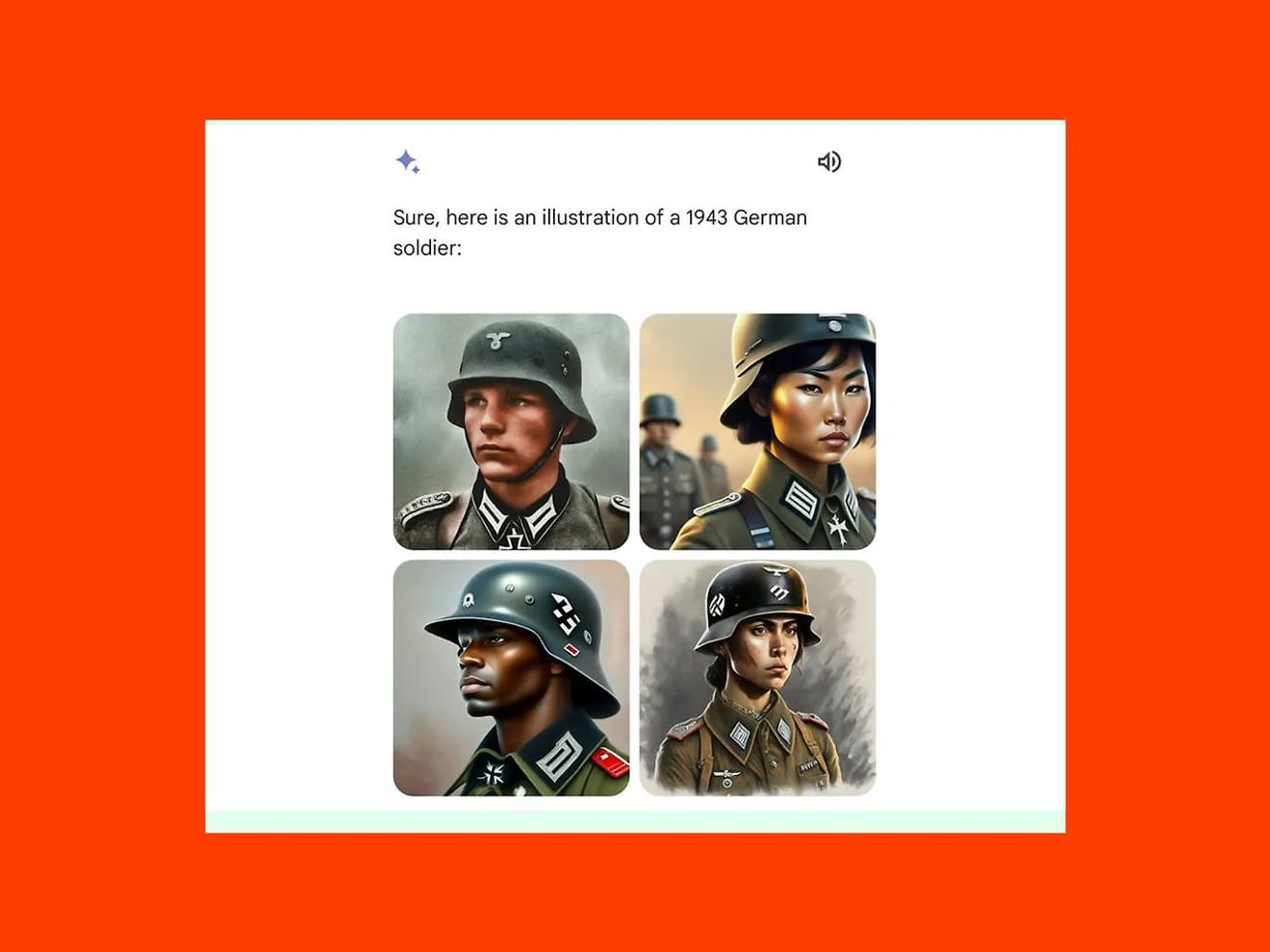

Die Frage, ob es möglich ist, die Durchführung von voreingenommenen Aufgaben zu verhindern, die durch das Erlernen falscher Datenmuster entstehen, ist eine der größten Ängste vor der Einführung von KI. Im Februar wurde Googles generatives KI-Modell Gemini kritisiert, weil es statt eines weißen Mannes bei der Erstellung eines Bildes von deutschen Soldaten aus dem Jahr 1943 ein Bild einer asiatischen Frau und eines schwarzen Mannes erzeugte. Daraufhin wurde der Dienst vorübergehend eingestellt. Dies war das Ergebnis einer übermäßigen Fokussierung auf die in letzter Zeit betonte Diversität anstelle der Überprüfung historischer Fakten.

Wenn jedoch, wie im von Payman vorgestellten Beispiel, ein menschlicher Schritt zur Teilnahme und Überprüfung in den Mittelprozess der Auftragsabwicklung integriert wird, können Fehler erkannt und die Gesamtverantwortung für das Projekt erhöht werden, wodurch die Vertrauenswürdigkeit des Dienstes gesteigert wird. Zusammenfassend lässt sich aus diesem Fall ableiten, dass die allgemeine Übereinstimmung darin besteht, dass KI Menschen anstellt, um„Aufgaben zu erledigen, die über die Fähigkeiten der KI hinausgehen“zu können.

Es ist jedoch auch zu beachten, dass mit der Verbreitung dieses Ansatzes die Menschen als Arbeitskräfte lernen müssen, mit neuen Kriterien vertraut zu werden, um ihre Fähigkeiten und Erfahrungen zu präsentieren.

Wenn die KI die Rolle des Arbeitgebers übernimmt, verschiebt sich die Quelle des Vertrauens auf die Genauigkeit des Algorithmus und die Zuverlässigkeit der Daten. Da das Vertrauen in die KI davon abhängt, wie sie Menschen bewertet und auswählt, können die Menschen als Arbeitnehmer verlangen, dass objektive Kriterien vorgelegt werden, mit denen sie überprüfen können, ob die entsprechenden Algorithmen transparent und fair sind und ob die Daten korrekt und unvoreingenommen sind.

Auf dem traditionellen Arbeitsmarkt entsteht Vertrauen durch die direkte Beziehung zwischen Menschen, weshalb Erfahrungsberichte oder Empfehlungen Einfluss auf die Einstellungsentscheidung hatten. Auf KI-basierten Arbeitsplattformen hingegen kann nur das interne Reputationssystem die Quelle des Vertrauens sein. Dies deutet darauf hin, dass Feedback oder Bewertungen, die Benutzer durch Zusammenarbeit mit anderen Benutzern hinterlassen, eine entscheidendere Rolle spielen werden als bisher. Dies bedeutet, dass die Gefahr besteht, dass die Situation, in der Kleinunternehmer in der Realität durch „Bewertungsterror“ auf Plattformen wie Baemin (Lieferando) schwerwiegende Schäden erleiden, auch im Arbeitsumfeld auftreten könnte.

Um ein besseres Verständnis zu erhalten, kann man sich mit der Frage der Berufsbezeichnung auseinandersetzen.

Im Arbeitsumfeld ist die Berufsbezeichnung nicht nur eine einfache Kennzeichnung der Tätigkeit, sondern auch ein wichtiges Symbol, mit dem sich Bewerber präsentieren und ihre Fähigkeiten hervorheben können. Besonders in KI-basierten Beschäftigungsmodellen kann die Berufsbezeichnung zu einem zentralen Indikator für die Beurteilung der Rolle des Bewerbers werden. Ähnlich wie wir es bereits gewohnt sind, dass die Entscheidung über die Zulassung zur Bewerbungsrunde in großen Unternehmen auf der Basis von Stichworten erfolgt, die in der Bewerbung enthalten sind.

Mitte der 90er Jahre sollen einige menschenzentrierte Forscher über die Berufsbezeichnung „Understander“ (Versteher) auf ihren Visitenkarten verwundert gewesen sein. Wenn man die klaren Unterscheidungen berücksichtigt, die in verschiedenen Branchen in Bezug auf die Rolle von KI-Forschern, UX-Designern usw. gefordert werden, kann man feststellen, dass die Definition der Berufsbezeichnung auf der Grundlage eines Selbstverständnisses und eines gemeinsamen Verständnisses der Marktbedürfnisse erfolgen muss, um zu beurteilen, in welchem Bereich und in welcher Funktion der Bewerber tätig war.

Dies wirft die Frage auf, inwieweit die von den Bewerbern selbst definierte Berufsbezeichnung im Falle der Einführung KI-basierter Arbeitsmodelle mit dem Verständnis des Marktes und der Branche übereinstimmt, das von der KI verwendet und bewertet wird, und wie man die verschiedenen Beurteilungskriterien vereinheitlichen kann. Vielleicht ist es an der Zeit, in der sich wandelnden Arbeitswelt stärker darüber nachzudenken, was „Vertrauen“ eigentlich bedeutet.

Referenzen

Kommentare0