Vor kurzem spielte sich innerhalb des Vorstands von OpenAI, einem gemeinnützigen Unternehmen, das innerhalb weniger Monate nach der Einführung von ChatGPT von null auf einen Jahresumsatz von 1 Milliarde US-Dollar wuchs, ein riesiges Drama ab. Der CEO des Unternehmens, Sam Altman, wurde entlassen und nach der Ankündigung seines Wechsels zu Microsoft wieder als CEO von OpenAI eingesetzt. Normalerweise ist der Gründer-CEO die stärkste Macht eines Unternehmens, daher ist es sehr selten, dass der Vorstand einen Gründer-CEO entlässt, und vor allem bei einem riesigen Unternehmen mit einem Unternehmenswert von 80 Milliarden US-Dollar würde man die Finger davon lassen.

Dennoch konnte sich dieses fünf Tage dauernde, spannende Drama entfalten, da OpenAI auf einer einzigartigen Struktur basiert, die an die Missionserklärung „für die Menschheit“ gebunden ist. Die drei unabhängigen Vorstandsmitglieder, die Berichten zufolge die Entscheidung über Altmans Entlassung leiteten, sind alle mit effektivem Altruismus (EA) verbunden, der mit der Mission des Unternehmens, „die Menschheit und alles im beobachtbaren Universum zu erhalten“, in Verbindung steht.

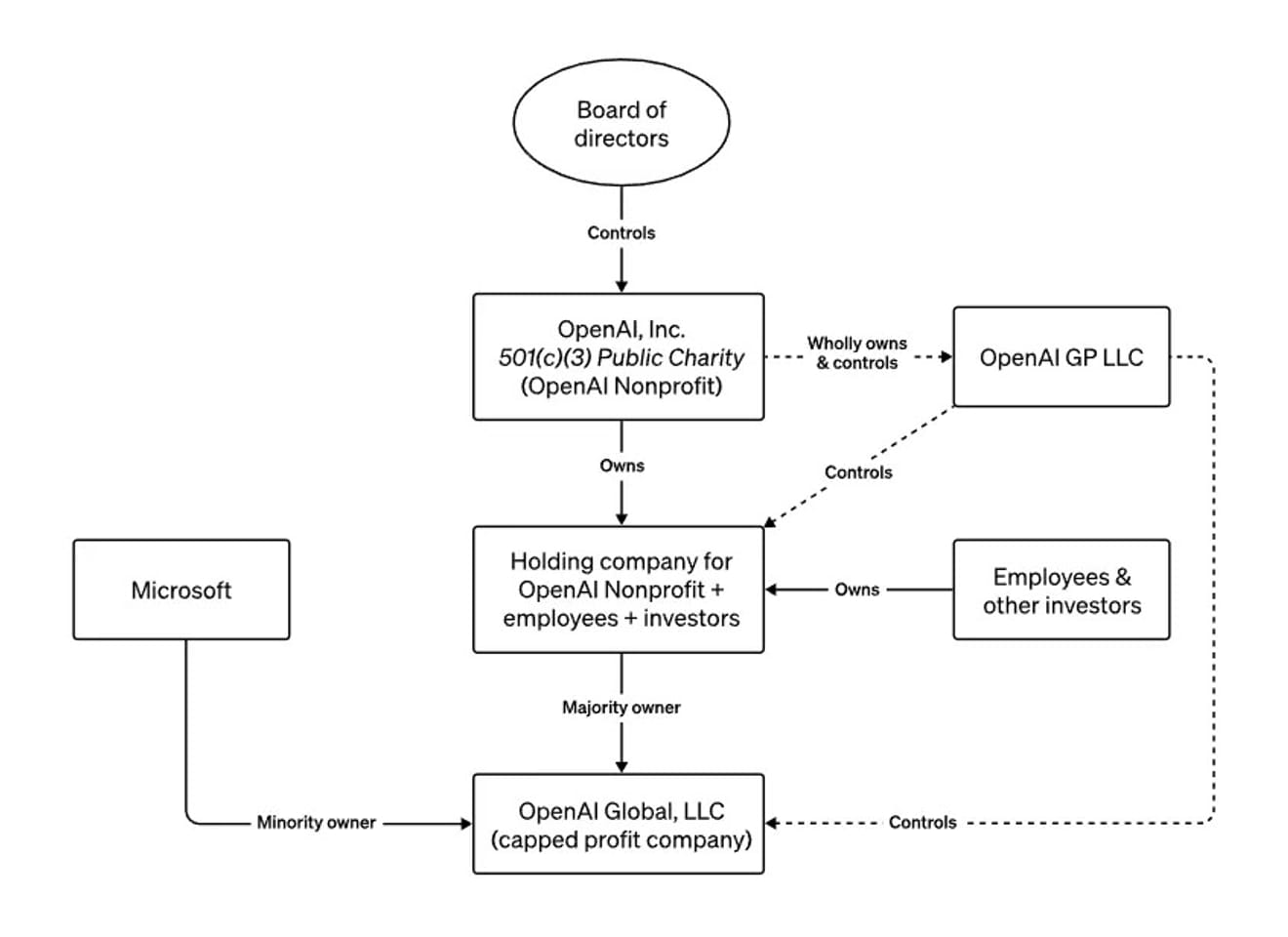

die Struktur des OpenAI-Vorstands

In diesem Jahr reiste Altman um die ganze Welt und warnte die Medien und Regierungen vor den existenziellen Risiken der von ihm entwickelten Technologie. Dabei beschrieb er die ungewöhnliche gemeinnützige/gewinnorientierte Struktur von OpenAI als eine Warnung vor der verantwortungslosen Entwicklung mächtiger KI. In einem Interview mit Bloomberg im Juni erwähnte er auch, dass der Vorstand ihn feuern könnte, wenn er sich gefährlich oder gegen das Interesse der Menschheit verhalten würde. Mit anderen Worten, es war eine Struktur, die absichtlich so konzipiert war, dass der Vorstand, der die Sicherheit über die Entstehung einer unkontrollierbaren AGI (Artificial General Intelligence) dem Geld vorzog, den CEO jederzeit entlassen konnte.

Wie sollen wir also die aktuelle Situation betrachten, in der der neue CEO von OpenAI derselbe ist wie der vorherige?

Dieser Vorfall lässt sich nicht einfach als ein Ereignis abtun, das letztendlich zu keiner Veränderung geführt hat. Denn wir haben festgestellt, dass Entscheidungen in Bezug auf die Entwicklung einer ethischen KI, die die größte Auswirkung auf unsere heutige Gesellschaft haben könnte, auf der Grundlage der Meinungen einer sehr kleinen Gruppe von Personen getroffen wurden. Sam Altman ist heute ein Symbol für eine Zeit, in der die ganze Welt ihre Aufmerksamkeit auf die Entwicklung und Regulierung von KI richtet. Und wir haben gesehen, dass das fast einzige Mittel von außen, das seine Entscheidungen hätte verhindern können, effektiv außer Kraft gesetzt wurde, wodurch die Bedeutung zusätzlicher externer Mittel für die Zukunft deutlich wird.

Darüber hinaus hat dieser Vorfall die Positionen und Interpretationen derjenigen, die befürchten, dass KI die Menschheit zerstören könnte (Apokalyptiker), derjenigen, die glauben, dass die Technologie eine utopische Zukunft beschleunigen wird (Transhumanisten), derjenigen, die an einen unregulierten Marktkapitalismus glauben, und derjenigen, die eine strenge Regulierung großer Technologieunternehmen befürworten, die glauben, dass das Gleichgewicht zwischen dem potenziellen Schaden durch starke, disruptive Technologien und dem Wunsch nach Profit nicht gefunden werden kann, klarer herausgestellt. Und da all dies letztendlich aus der Angst vor der Zukunft der Menschheit mit KI entsteht, ist es wichtig zu beachten, dass dies die Notwendigkeit einer größeren Bandbreite an Communities verdeutlicht, die in der Lage sind, diese Zukunft vorherzusagen.

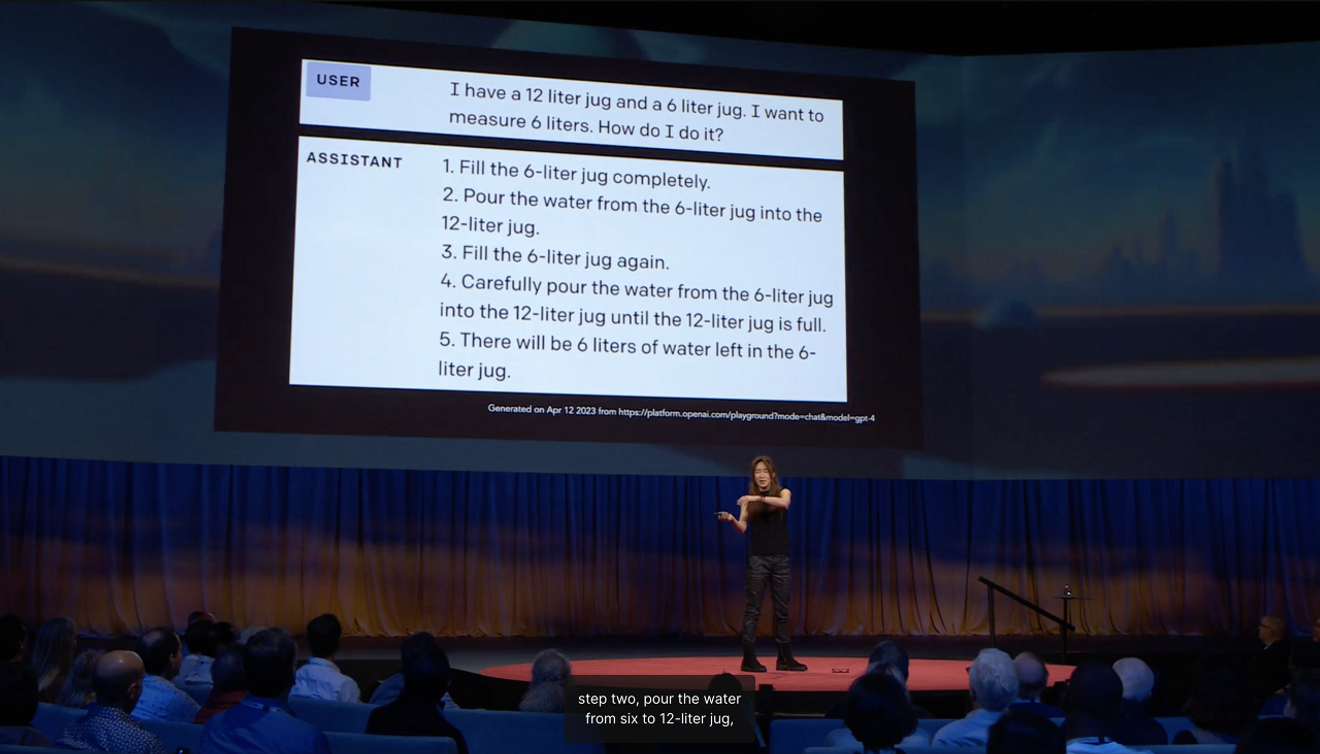

Yejin Choi, Professorin an der University of Washington, die zu den 100 einflussreichsten Persönlichkeiten im Bereich der KI weltweit gehört, erklärte in ihrem TED-Talk, dass der Grund, warum eine KI, die verschiedene staatliche Prüfungen besteht, bei der Messung der Wassermenge von 6 Litern mit Hilfe von 12-Liter- und 6-Liter-Kannen unnötige, dumme Schritte einfügt, darin besteht, dass es an der Ausbildung von „Gesundem Menschenverstand“ liegterklärt sie.

Wenn wir die Zukunft voraussagen, identifizieren wir oft aus der Perspektive eines Außenstehenden Neues, indem wir uns auf die „Grenzen“ konzentrieren, die die Richtung des Mainstreams anzeigen. In diesem Fall basiert das, was aus der Außenperspektive als stabile Zukunftsvision erscheint, immer bis zu einem gewissen Grad auf der Gegenwart und ist eine „Lebendige Erfahrung“, die aus der Abstraktion von Erwartungen stammt. Der amerikanische Anthropologe Arjun Appadurai argumentierte, dass Vorstellungskraft keine private und individuelle Fähigkeit, sondern eine soziale Praxis ist. Dies bedeutet, dass verschiedene Zukunftsvorstellungen Wirklichkeit werden können, und dieser Vorfall kann als eine der Landschaften interpretiert werden, die durch die Vorstellungskraft einer unsicheren Zukunft im Zusammenhang mit dem Aufkommen von AGI geschaffen wurden.

Da wir festgestellt haben, dass die Erwartungen der Branchenführer an die Zukunft eine politisch wichtige Bedeutung haben, wird es in Zukunft notwendig sein, ein tieferes Verständnis der Zukunft zu entwickeln, die in verschiedenen sozialen und kulturellen Kontexten kollektiv vorgestellt und konstruiert wird, um die Zukunft der KI zu bestimmen. Es ist an der Zeit, die Frage zu stellen, wie man Möglichkeiten schaffen kann, um kollektive Erwartungen zu fördern, die auf lebendigen Erfahrungen innerhalb verschiedener Communities basieren.

Referenzen

Kommentare0