Hace poco tiempo, unos meses después del lanzamiento de ChatGPT, se desarrolló un drama inmenso dentro del consejo de administración de OpenAI, una organización sin ánimo de lucro que pasó de tener cero ingresos a generar 1.000 millones de dólares anuales. El CEO de la compañía, Sam Altman, fue despedido y, tras anunciar su incorporación a Microsoft, finalmente regresó a su puesto como CEO de OpenAI. Normalmente, el CEO fundador es la figura más poderosa de una empresa, por lo que es muy poco común que el consejo de administración lo despida, especialmente en el caso de una gran empresa con un valor de mercado de 80.000 millones de dólares, a la que nadie se atreve a tocar.

A pesar de ello, este tenso drama de cinco días pudo ocurrir gracias a la peculiar estructura de OpenAI, que está ligada a su declaración de misión de "beneficiar a la humanidad". Los tres miembros independientes del consejo de administración que, según se informa, impulsaron la decisión de despedir a Altman, están todos relacionados con el altruismo efectivo (EA, effective altruism), que tiene que ver con el cumplimiento de la misión de la compañía de "evitar que la humanidad y todo lo que existe en el universo observable desaparezcan".

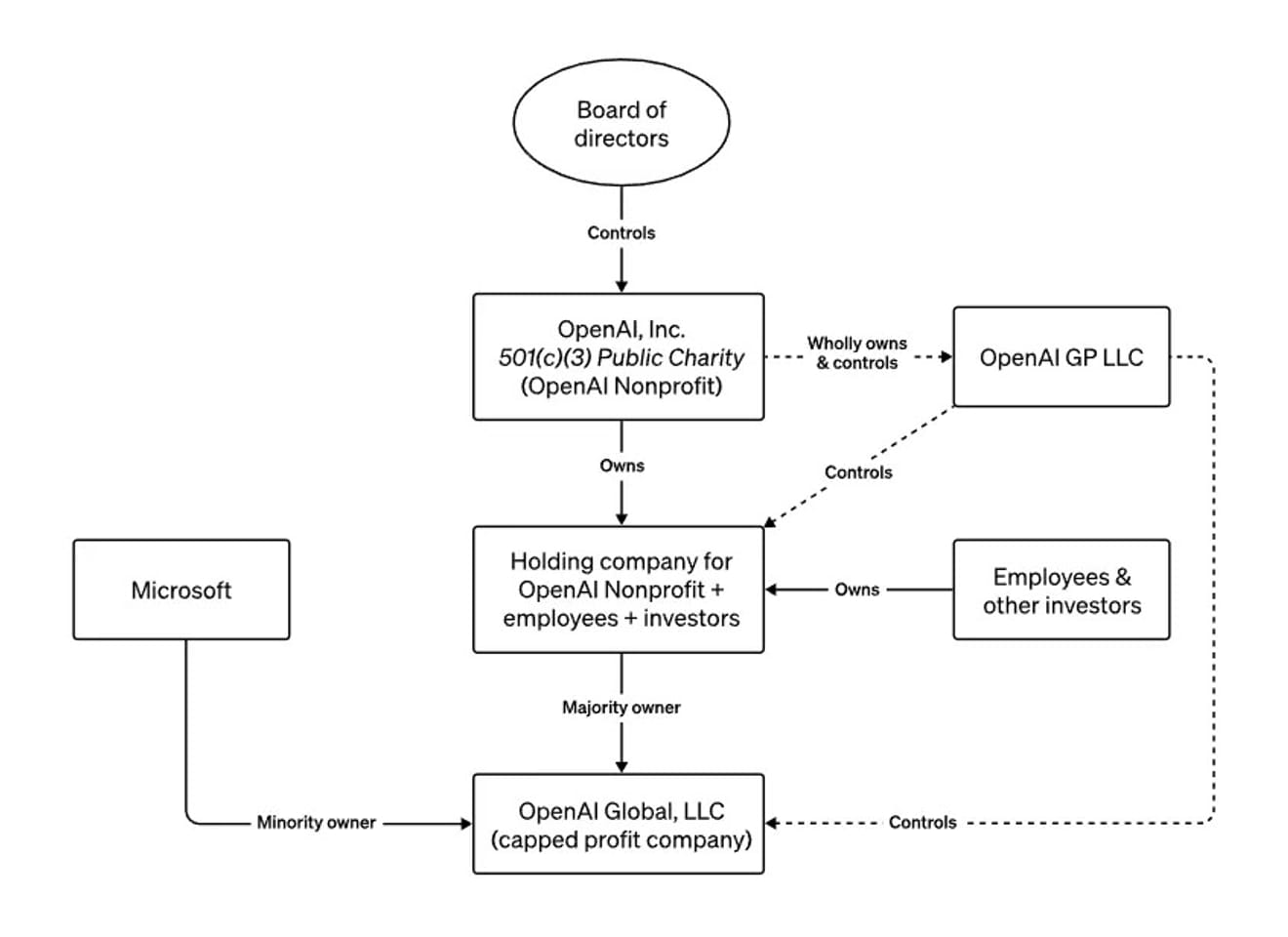

la estructura de la junta directiva de OpenAI

Durante todo este año, Altman ha viajado por todo el mundo advirtiendo a los medios de comunicación y a los gobiernos sobre los riesgos existenciales de la tecnología que está desarrollando. Ha descrito la peculiar estructura de OpenAI, una organización sin ánimo de lucro con fines de lucro, como una advertencia contra el desarrollo irresponsable de IA potente. En una entrevista con Bloomberg en junio, también mencionó que si realizaba acciones peligrosas o que fueran contrarias a los intereses de la humanidad, el consejo de administración podría despedirlo. En otras palabras, la estructura fue diseñada intencionadamente para que un consejo de administración que prioriza la seguridad por encima del dinero, y especialmente ante la posibilidad de la aparición de una IA general (AGI) incontrolable, pudiera despedir al CEO en cualquier momento.

¿Cómo debemos interpretar entonces la situación actual, en la que el nuevo CEO de OpenAI es el mismo que el anterior?

No podemos concluir que este asunto se ha resuelto con un simple incidente sin cambios. Lo que ha quedado patente es que las decisiones relacionadas con el desarrollo de la IA ética, que podría tener el mayor impacto en nuestra sociedad actual, se tomaron basándose únicamente en las opiniones de un grupo muy reducido de personas. Sam Altman se ha convertido en un símbolo de esta época en la que la atención mundial se centra en el desarrollo y la regulación de la IA. Hemos sido testigos de cómo el único medio externo que podía haber frenado sus decisiones y acciones fue esencialmente descartado, y esto nos hace comprender la importancia de contar con mecanismos externos adicionales en el futuro.

Además, este incidente ha aclarado aún más las posiciones de diferentes grupos de personas: los catastrofistas que temen que la IA destruya la humanidad, los transhumanistas que creen que la tecnología acelerará la llegada de un futuro utópico, los defensores del libre mercado capitalista, y quienes abogan por una estricta regulación de las grandes empresas tecnológicas para controlar el potencial daño de las tecnologías disruptivas y el deseo de obtener beneficios. Todas estas perspectivas tienen su origen en el miedo al futuro de la humanidad junto con la IA, lo que destaca la necesidad de crear una mayor variedad de comunidades para predecir este futuro.

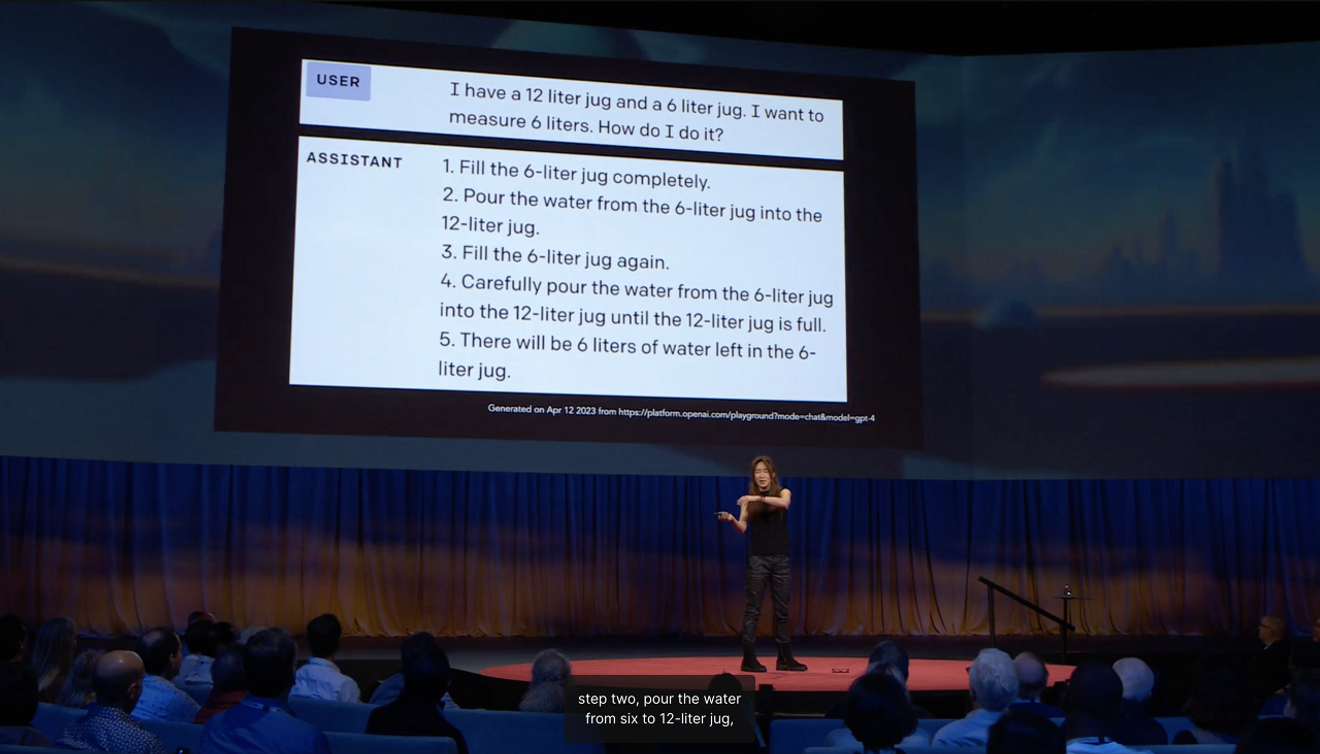

La profesora Ye-Jin Choi de la Universidad de Washington, incluida en la lista de las 100 personas más influyentes del mundo en el campo de la IA, explicó en su charla TED que la razón por la que una IA capaz de aprobar todo tipo de exámenes de ingreso a la función pública añade pasos innecesarios e inútiles al medir la cantidad de 6 litros de agua con jarras de 12 y 6 litros es debido a la falta de aprendizaje del sentido común en la sociedad.

Cuando predecimos el futuro, a menudo identificamos lo nuevo desde una perspectiva externa, basándonos en los "límites" que indican hacia dónde se dirige la corriente principal. En este caso, lo que desde fuera se ve como una visión estable del futuro siempre se basa, hasta cierto punto, en una expectativa abstracta derivada de una "experiencia vívida"referente al presente. El antropólogo estadounidense Arjun Appadurai argumentó que la imaginación no es una capacidad privada e individual, sino una práctica social. Esto significa que la imaginación de diversos futuros puede convertirse en realidad. Este incidente puede interpretarse como uno de los paisajes creados por la imaginación de un futuro incierto relacionado con la aparición de la IA general.

Dado que hemos confirmado que las expectativas de los líderes de la industria sobre el futuro tienen un significado político importante, en el futuro será necesario comprender más a fondo los futuros imaginados y construidos colectivamente en diversos contextos sociales y culturales para decidir el futuro de la IA. Es hora de preguntarnos cómo podemos crear oportunidades para que se presenten activamente las expectativas colectivas basadas en experiencias vívidas dentro de diversas comunidades.

Referencias

Comentarios0