El pasado miércoles, se lanzó oficialmente Udio, un servicio de generación de música con IA que permite crear música a través de indicaciones de texto e incluso agregar elementos como voces y letras. Después de varios meses en fase beta privada, este servicio es el resultado del trabajo de un equipo formado por antiguos empleados de Google DeepMind. Udio ha generado gran expectación al recibir una financiación inicial de 10 millones de dólares de inversores y personalidades destacadas como el músico will.i.am y Common.

Lo que resulta interesante es que los revisores que tuvieron la oportunidad de probar Udio con el apoyo del equipo, coinciden en que la experiencia de la música generada por IA es de un nivel muy alto, especialmente en aspectos como la sensación de estar en una actuación en vivo y la armonía vocal. Además, se destaca la simplificación del proceso de creación musical, lo que abre la posibilidad de que cualquier persona pueda convertirse en compositor. De este modo, las noticias apuntan a una posible revolución en la forma en que se crea y se consume la música en el futuro.

Este avance es otro ejemplo de la tendencia en el ámbito de la IA que busca democratizar la expresión creativa, permitiendo que más personas accedan a herramientas de creación artística. Sin embargo, junto con el debate sobre las posibilidades que ofrece su eficiencia y su interfaz fácil de usar, también surgen interrogantes que deben tenerse en cuenta.

Estas herramientas ¿pueden reproducir la complejidad del significado y la profundidad emocional que los creadores humanos infunden en sus obras? Esta pregunta es fundamental para comprender el potencial y las limitaciones de la IA en el futuro de la industria creativa.

El músico HAINBACH, a través de su contenido de YouTube "How Textures Tell a Story" (Cómo las texturas cuentan una historia), nos permite experimentar cómo estos sonidos electrónicos incontrolables se perciben con diferentes significados e historias según el lugar en el que nos encontramos, mientras nos trasladamos a través de un tranquilo parque y la naturaleza llena de hierba y árboles. Para él, Lyra-8 es un instrumento que da forma a una narrativa única adaptada al contexto sensorial y cultural del sonido.

El fabricante, Soma, describe Lyra-8 como un sintetizador "orgánico", ya que su característica principal es una superficie táctil capacitiva que interactúa con las características físicas del usuario, como la sensibilidad al tacto, la humedad y la temperatura, en lugar de seguir el diseño tradicional de teclado. Esto crea un entorno más íntimo y físicamente inmersivo para el usuario, lo que profundiza la interacción y hace que la experiencia de crear sonido sea muy personal e investigadora. Y esto es un ejemplo del tipo de experiencia sonora rica y multifacética que la IA aún no puede reproducir de manera convincente.

El mundo ya está saturado de pitidos, "bip" y fragmentos musicales. Pasamos la mayor parte del tiempo en pantallas de monitores y dispositivos que están saturados de sonidos sin profundidad ni contexto relevante. Por eso, la noticia del lanzamiento de un nuevo servicio de generación de música con IA resulta tan intrigante como preocupante. En esencia, creemos que las tecnologías de IA como Udio no solo deben imitar la capacidad musical humana, sino que también deben tener como objetivo comprender y reflejar la compleja estructura emocional y cultural que sustenta la creatividad humana.

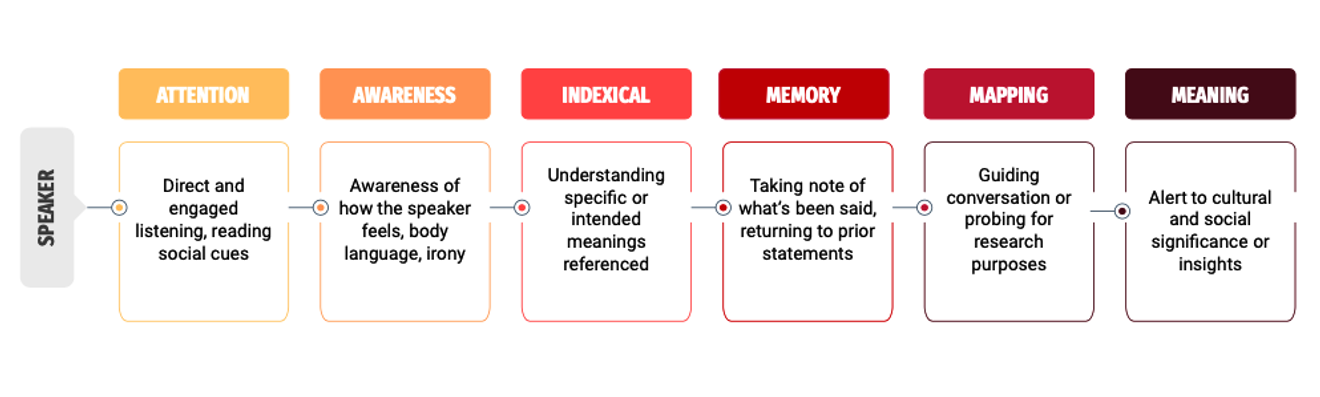

El antropólogo cultural Michael Powell, en su artículo "The Sound of Friction" (El sonido de la fricción), destaca que la "escucha" es una técnica muy eficaz para comprender la experiencia humana y los elementos de interacción cultural. De su investigación se pueden extraer las siguientes ideas que las empresas que desarrollan servicios de generación de música con IA deberían tener en cuenta en el futuro.

Primero, un bucle de retroalimentación interactiva podría ser apropiado. Se podría considerar la integración de un sistema que, aplicando el proceso iterativo de las entrevistas etnográficas, haga que la IA formule preguntas de seguimiento en respuesta a la entrada de texto básica o que ajuste y refine la música generada reflejando las respuestas iniciales del usuario.

En segundo lugar, se podría intentar ofrecer resultados personalizados mediante un análisis sutil que tenga en cuenta la textura cultural relacionada con el tono emocional o las referencias que se incluyen en el texto de entrada básico.

En tercer lugar, al igual que un etnógrafo profundiza en sus conocimientos a medida que avanza su investigación, se podría considerar el diseño de una extensión del historial de conversaciones que permita al sistema de IA ampliar su comprensión de las preferencias del usuario y los matices culturales.

La IA como Udio representa un avance significativo en el aumento de la accesibilidad a la creación musical. Sin embargo, también nos insta a reflexionar sobre cómo podemos complementar la esencia de la creatividad y la conexión con las sutiles experiencias humanas que la música puede brindar. Este diálogo entre la tecnología y la tradición, la innovación y la profundidad, definirá la trayectoria futura de la música en la era digital. Por lo tanto, además de considerar cómo se crea el sonido, es importante reflexionar sobre cómo se percibe y valora el sonido en nuestra sociedad. Esto podría ser la mejor manera de retrasar, aunque sea un poco, la llegada de una era en la que las "creaciones humanas" se conviertan en una etiqueta de alto precio.

Referencias

Comentarios0