Un nouveau type de marché du travail émerge.

Il y a quelques semaines, Payman AI a lancé un service d'IA qui rémunère les humains (AI that Pays Humans), actuellement en phase de test bêta privé. Ce service explique que le client effectue un paiement sur le compte de l'agent IA de Payman, puis accorde à l'IA l'accès à des tâches du monde réel qui ne peuvent être effectuées que par des humains.

À titre d'exemple, le projet de « collecte de 10 avis dans le cadre d'une activité de gestion de la clientèle » montre comment l'IA spécifie et organise les éléments minimaux des avis demandés par le client et les partage sur la plateforme. Les personnes intéressées par cette demande se rendent ensuite dans le monde réel pour collecter et soumettre les avis. L'IA vérifie ensuite l'adéquation des avis et verse aux personnes concernées les frais qui leur ont été attribués.

Cette méthode peut sembler être un simple cas d'utilisation de l'IA pour le moment. Toutefois, elle mérite d'être remarquée car elle fournit au moins un indice pour résoudre le problème le plus courant et le plus difficile à résoudre dans le cadre de l'adoption de l'IA : la « confiance ».

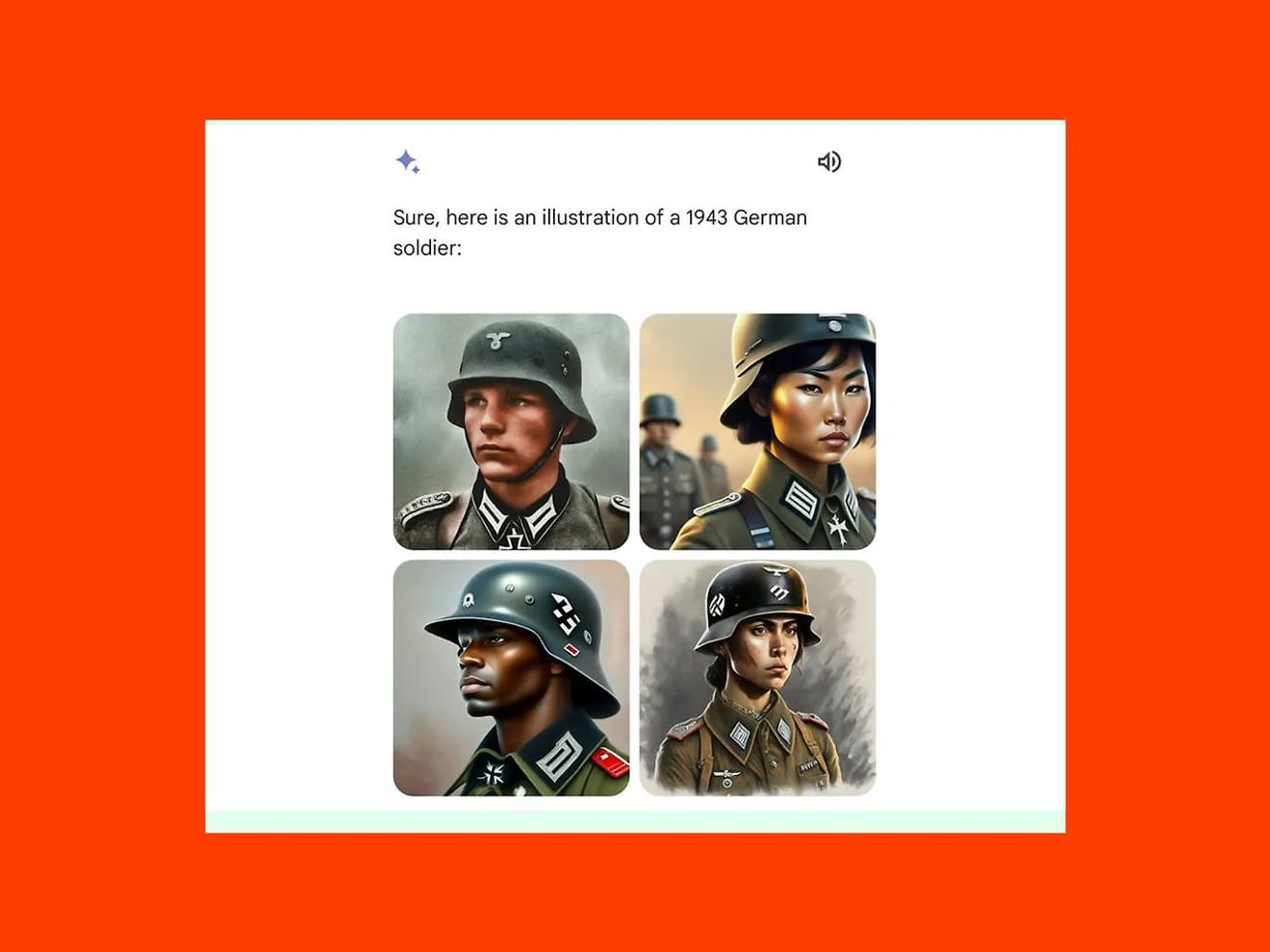

L'une des principales craintes concernant l'adoption de l'IA est de savoir si l'on peut éviter que l'IA n'effectue des tâches biaisées en apprenant des modèles de données erronés. En février dernier, Gemini, le modèle d'IA générative de Google, a été critiqué pour avoir généré des images de femmes asiatiques et d'hommes noirs à la place d'hommes blancs sur des images de soldats allemands de 1943, ce qui a conduit à la suspension temporaire du service. C'est le résultat d'une focalisation excessive sur la diversité, qui a pris le pas sur la vérification des faits historiques.

Cependant, comme le montre l'exemple de Payman, l'intégration d'une étape de participation et d'examen humaine dans le processus intermédiaire d'une demande permet de détecter les erreurs et d'accroître la responsabilité globale du projet, ce qui augmente la fiabilité du service. En résumé, l'accord général qui ressort de ce cas est que l'IA emploie des humains pour « « réaliser des tâches qui dépassent les capacités de l'IA » ».

Toutefois, à mesure que cette approche se généralise, il est important de noter que les humains, en tant que travailleurs, devront s'habituer à des critères différents pour mettre en avant leurs compétences et leur expérience.

Premièrement, dans un contexte où l'IA joue le rôle d'employeur, la source de confiance se déplace vers la précision des algorithmes et la fiabilité des données. Le niveau de confiance est déterminé par la manière dont l'IA évalue et sélectionne les personnes. Par conséquent, en tant que travailleurs, les humains qui postulent à un projet pourraient exiger que des critères externes soient mis en place pour vérifier la transparence et l'équité des algorithmes concernés, ainsi que l'exactitude et l'absence de biais des données.

De plus, sur le marché du travail traditionnel, la confiance se forge dans le cadre d'une relation directe entre personnes. Les recommandations et les références influaient sur les décisions d'embauche. Sur une plateforme d'emploi basée sur l'IA, seul le système de réputation interne peut être une source de confiance. Cela laisse entrevoir que les commentaires et les évaluations laissés par les utilisateurs sur d'autres utilisateurs avec lesquels ils ont collaboré auront un rôle encore plus déterminant qu'auparavant. Cela signifie qu'il est probable que les situations de « harcèlement par notation » que l'on observe dans le monde réel avec les commerçants indépendants sur des plateformes comme Deliveroo se reproduisent également dans le contexte de l'emploi.

Pour une meilleure compréhension, on peut s'intéresser à la question de l'intitulé du poste.

Dans le contexte de l'emploi, l'intitulé du poste ne se contente pas de décrire la fonction, mais constitue également un symbole important pour les candidats afin qu'ils puissent mettre en avant leur valeur et leurs compétences. Dans un modèle d'emploi basé sur l'IA, l'intitulé du poste peut servir d'indicateur essentiel pour déterminer le rôle du candidat. Tout comme nous avons déjà l'habitude de voir les décisions d'admission à un processus de recrutement en entreprise se baser sur des critères technologiques axés sur les mots-clés.

Au milieu des années 1990, certains chercheurs axés sur l'humain auraient trouvé étrange le titre « Understander » qui figurait sur leur carte de visite. Si l'on considère la distinction claire entre les différents rôles requis par les secteurs d'activité en fonction des chercheurs en IA, des concepteurs UX, etc., on constate que la définition de l'intitulé du poste doit reposer sur une auto-perception et une compréhension commune des besoins du marché pour déterminer le rôle et le domaine d'expertise du candidat.

Cela soulève la question de savoir, dans un contexte où l'emploi est basé sur l'IA, dans quelle mesure l'intitulé du poste que le candidat définit lui-même correspondra aux critères de compréhension du marché et du secteur d'activité utilisés par l'IA et comment définir des critères de jugement variés et universels. Peut-être est-ce le moment de se poser des questions plus profondes sur la notion de « confiance » dans un marché du travail en pleine mutation.

Références

Commentaires0