कुछ समय पहले, ChatGPT के लॉन्च के कुछ महीनों बाद, एक गैर-लाभकारी संगठन OpenAI, जिसने कुछ ही समय में शून्य से 1 बिलियन डॉलर का वार्षिक राजस्व अर्जित किया था, के बोर्ड में एक बड़ा नाटक हुआ। कंपनी के सीईओ सैम ऑल्टमैन को हटा दिया गया था, और माइक्रोसॉफ्ट में उनके जाने की घोषणा के बाद, उन्हें फिर से OpenAI का सीईओ नियुक्त कर दिया गया। आमतौर पर, संस्थापक सीईओ कंपनी की सबसे मजबूत शक्ति होते हैं, इसलिए बोर्ड द्वारा संस्थापक सीईओ को हटाना बहुत ही दुर्लभ होता है, और खासकर जब किसी कंपनी का मूल्य 80 बिलियन डॉलर हो, तो कोई भी इस तरह का जोखिम नहीं उठाता है।

लेकिन फिर भी, इस तरह का 5 दिनों का नाटकीय घटनाक्रम OpenAI की अनोखी संरचना के कारण संभव हो सका, जो 'मानव जाति के लिए' अपने मिशन स्टेटमेंट से बंधा हुआ है। 'मानव जाति और अवलोकनीय ब्रह्मांड के सभी को नष्ट होने से बचाने' के लक्ष्य को ध्यान में रखते हुए, तीन स्वतंत्र बोर्ड सदस्यों ने ऑल्टमैन को हटाने का नेतृत्व किया, जिनके बारे में बताया गया है कि वे सभी कंपनी के मिशन से जुड़े प्रभावी परोपकार (EA, effective altruism) से संबंधित हैं।

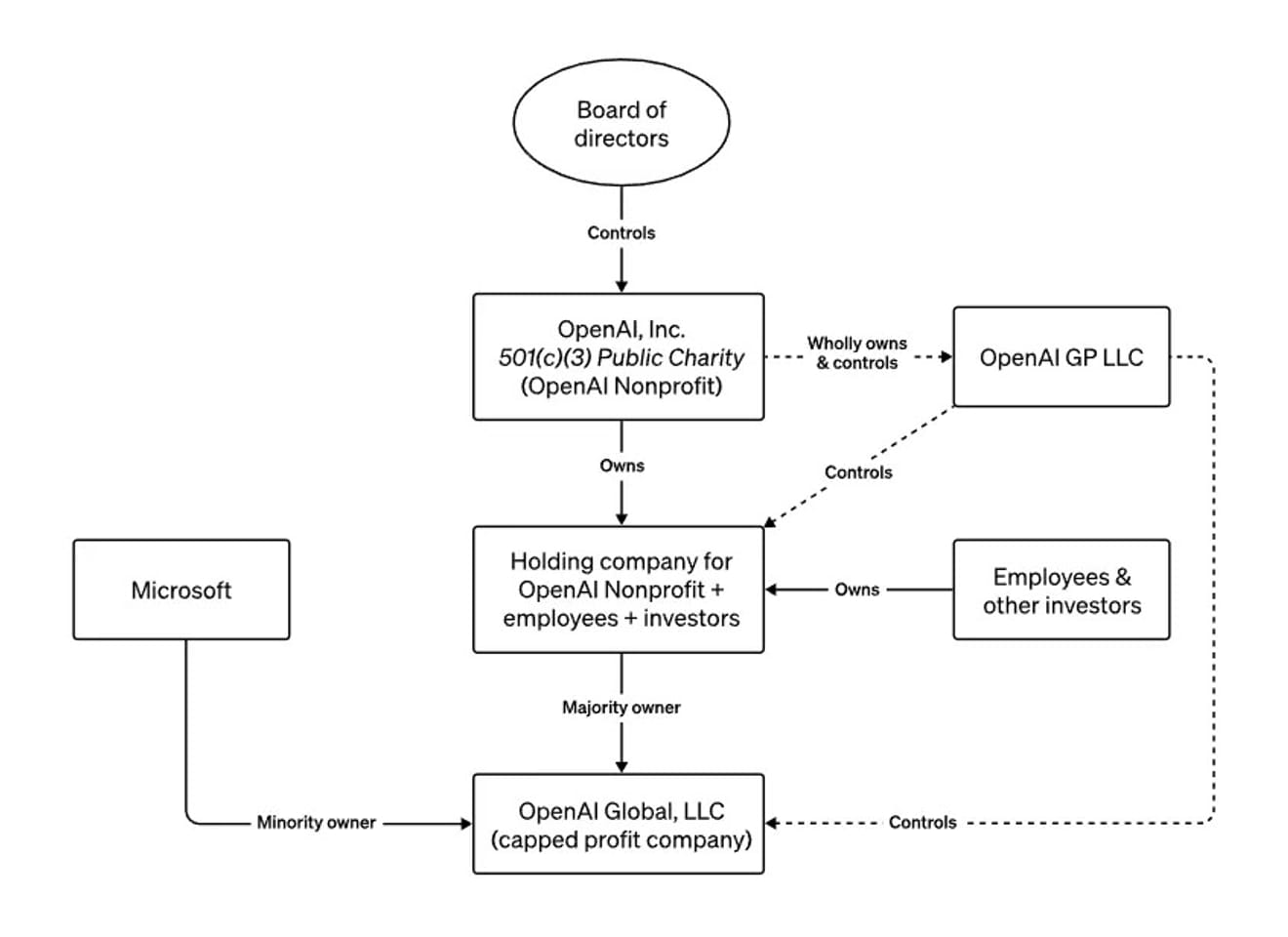

OpenAI की बोर्ड संरचना (the board structure of OpenAI)

पूरे साल, ऑल्टमैन ने मीडिया और सरकारों के सामने अपनी विकसित तकनीक के अस्तित्वगत जोखिमों के बारे में चेतावनी देते हुए दुनिया भर का दौरा किया है। उन्होंने OpenAI की अनोखी गैर-लाभकारी-अंदर-लाभकारी संरचना का वर्णन AI के गैर-जिम्मेदाराना विकास के बारे में एक चेतावनी के रूप में किया है। उन्होंने जून में ब्लूमबर्ग के साथ एक साक्षात्कार में कहा था कि अगर वे खतरनाक या मानव जाति के हित के खिलाफ कोई काम करते हैं, तो बोर्ड उन्हें बाहर निकाल सकता है। दूसरे शब्दों में, यह एक ऐसी संरचना है जिसे जानबूझकर इस तरह से डिज़ाइन किया गया था कि बोर्ड, जो AGI के अनियंत्रित उद्भव से जुड़े जोखिमों को पैसे से ज़्यादा महत्व देता है, सीईओ को किसी भी समय हटा सकता है।

तो, इस वर्तमान स्थिति में, जहां OpenAI के नए CEO पिछले सीईओ के समान ही हैं, हमें इसे कैसे देखना चाहिए?

इस परिणाम को एक ऐसी घटना के रूप में खारिज करना मुश्किल है जिसका कोई परिणाम नहीं निकला। ऐसा इसलिए है क्योंकि हमने देखा है कि हमारे समाज को सबसे ज़्यादा प्रभावित करने वाले नैतिक AI विकास से संबंधित निर्णय केवल कुछ लोगों के विचारों से ही लिए गए थे। सैम ऑल्टमैन अब उस युग के प्रतीक हैं जहां AI विकास और विनियमन पर दुनिया भर की निगाहें टिकी हैं। और हमने देखा है कि उनके फैसलों और कार्यों को रोकने का लगभग एकमात्र बाहरी तरीका असल में समाप्त कर दिया गया है, और इस घटना के बाद बाहरी माध्यमों के महत्व की पुष्टि हुई है।

इस घटना ने AI के विनाशकारी परिणामों की चिंता करने वाले सर्वनाशवादी (पारामर्श), उन ट्रांसह्यूमनिस्टों के विचारों को और स्पष्ट कर दिया है जो मानते हैं कि प्रौद्योगिकी एक आदर्श भविष्य को जन्म देगी, मुक्त बाजार पूंजीवाद में विश्वास करने वाले लोग, और कठोर नियमों का समर्थन करने वाले लोग जो मानते हैं कि बड़ी तकनीकी कंपनियों को नियंत्रित करने और विनाशकारी तकनीकों के संभावित नुकसान और मुनाफे के बीच संतुलन बनाने का कोई तरीका नहीं है। और यह सब AI के साथ मानव जाति के भविष्य के प्रति डर से शुरू होता है, इसलिए इस भविष्य का अनुमान लगाने वाले व्यक्तियों के बारे में पता लगाना आवश्यक है, और इसके लिए विभिन्न समुदायों की ज़रूरत पर ज़ोर देने की आवश्यकता है।

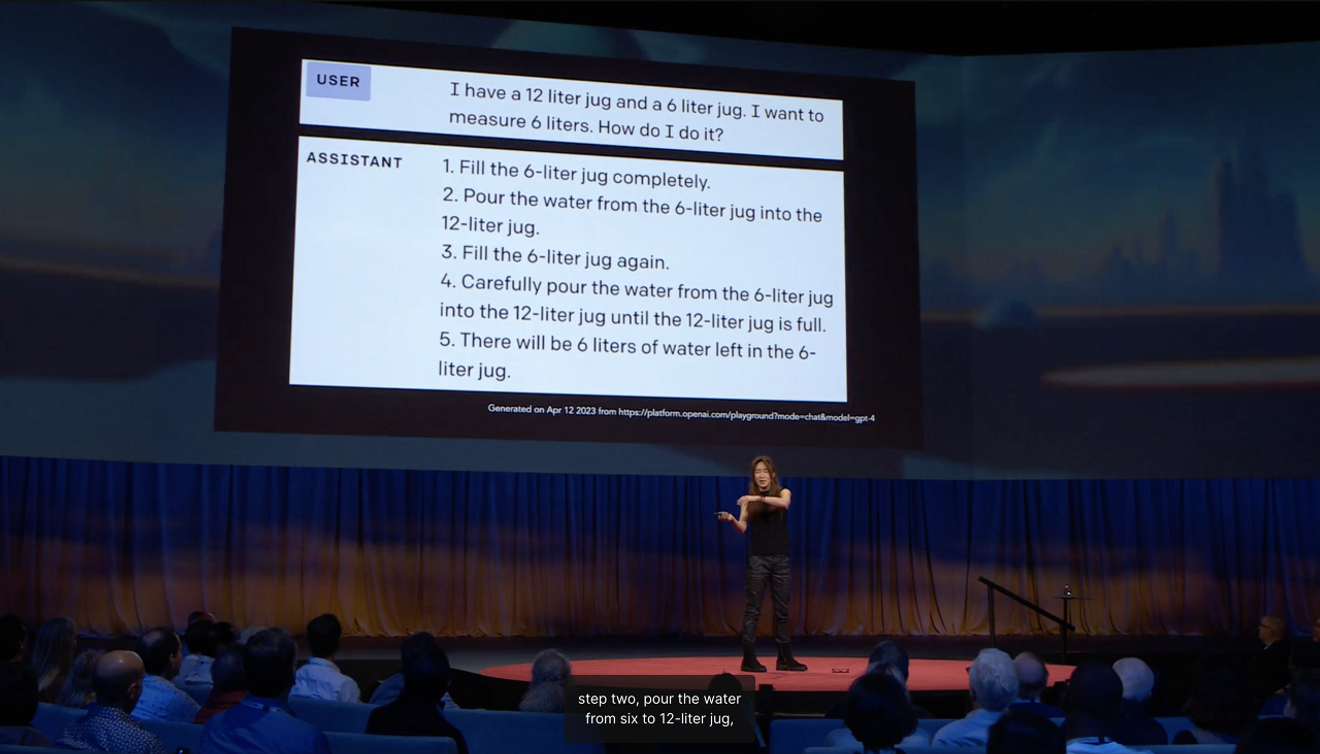

विश्व AI क्षेत्र के 100 सबसे प्रभावशाली लोगों में शामिल वाशिंगटन विश्वविद्यालय की प्रोफेसर चोई येजिन ने अपने TED व्याख्यान में बताया कि विभिन्न राष्ट्रीय परीक्षाओं को पास करने वाले AI द्वारा 12 लीटर और 6 लीटर के जगों से 6 लीटर पानी मापने के लिए अनावश्यक कदम उठाने का कारण मानवों द्वारा समाज में प्राप्त होने वालेसामान्य ज्ञान की कमी है।यह समझाते हुए उन्होंने कहा।

जब हम भविष्य का अनुमान लगाते हैं, तो हम अक्सर 'सीमा' को आधार मानते हैं जो यह दर्शाता है कि मुख्यधारा कहाँ जा रही है, और एक बाहरी व्यक्ति के रूप में कुछ नया पहचानते हैं। इस समय, बाहर से एक स्थिर भविष्य के दृष्टिकोण के रूप में जो दिखाई देता है, वह हमेशा वर्तमान को आधार मानकर“व्यक्तिगत अनुभवों से प्राप्त अपेक्षाएँ”होती हैं। अमेरिकी मानवविज्ञानी अर्जुन अपादुराई ने कल्पना को एक निजी और व्यक्तिगत क्षमता के बजाय एक सामाजिक अभ्यास बताया है। इसका अर्थ है कि विभिन्न भविष्य के बारे में कल्पना वास्तविकता में बदल सकती है, और इस घटना को AGI के आगमन से संबंधित भविष्य के बारे में चिंताजनक कल्पनाओं के परिणामस्वरूप पैदा हुए परिदृश्यों में से एक के रूप में व्याख्यायित किया जा सकता है।

चूँकि हमने देखा है कि उद्योग के नेताओं की भविष्यवाणियों का राजनीतिक रूप से महत्वपूर्ण अर्थ है, इसलिए भविष्य में AI के भविष्य को निर्धारित करने के लिए विभिन्न सामाजिक और सांस्कृतिक संदर्भों में सामूहिक रूप से कल्पना और निर्मित भविष्य की गहरी समझ की आवश्यकता होगी। विभिन्न समुदायों के व्यक्तिगत अनुभवों पर आधारित सामूहिक अपेक्षाओं को सक्रिय रूप से प्रस्तुत करने के अवसर पैदा करना कैसे संभव है, इस पर सवाल उठाने का समय आ गया है।

संदर्भ

टिप्पणियाँ0