Sta emergendo un nuovo tipo di mercato del lavoro.

Qualche settimana fa, Payman AI ha rilasciato un servizio di intelligenza artificiale che paga gli umani (AI that Pays Humans), sebbene sia ancora in fase di beta testing privata. Il servizio spiega che il committente effettua un pagamento sul conto dell'agente AI di Payman e concede all'AI l'autorizzazione ad accedere a compiti che solo gli umani possono svolgere nel mondo reale.

Ad esempio, il progetto 'Raccolta di 10 recensioni per attività di gestione clienti' mostra come l'AI concretizzi e organizzi i requisiti minimi per le recensioni richieste dal committente, condividendoli sulla piattaforma. Le persone interessate a questo incarico si recano nel mondo reale per raccogliere e inviare le recensioni. L'AI valuta l'adeguatezza delle recensioni e, una volta verificata, eroga il pagamento a ciascuna persona in base alla quota assegnata.

Questo tipo di approccio potrebbe sembrare ancora un semplice esempio di applicazione dell'intelligenza artificiale. Tuttavia, è degno di nota perché fornisce almeno un indizio per affrontare il collo di bottiglia più comune e difficile da risolvere nell'adozione dell'AI: la 'fiducia'.

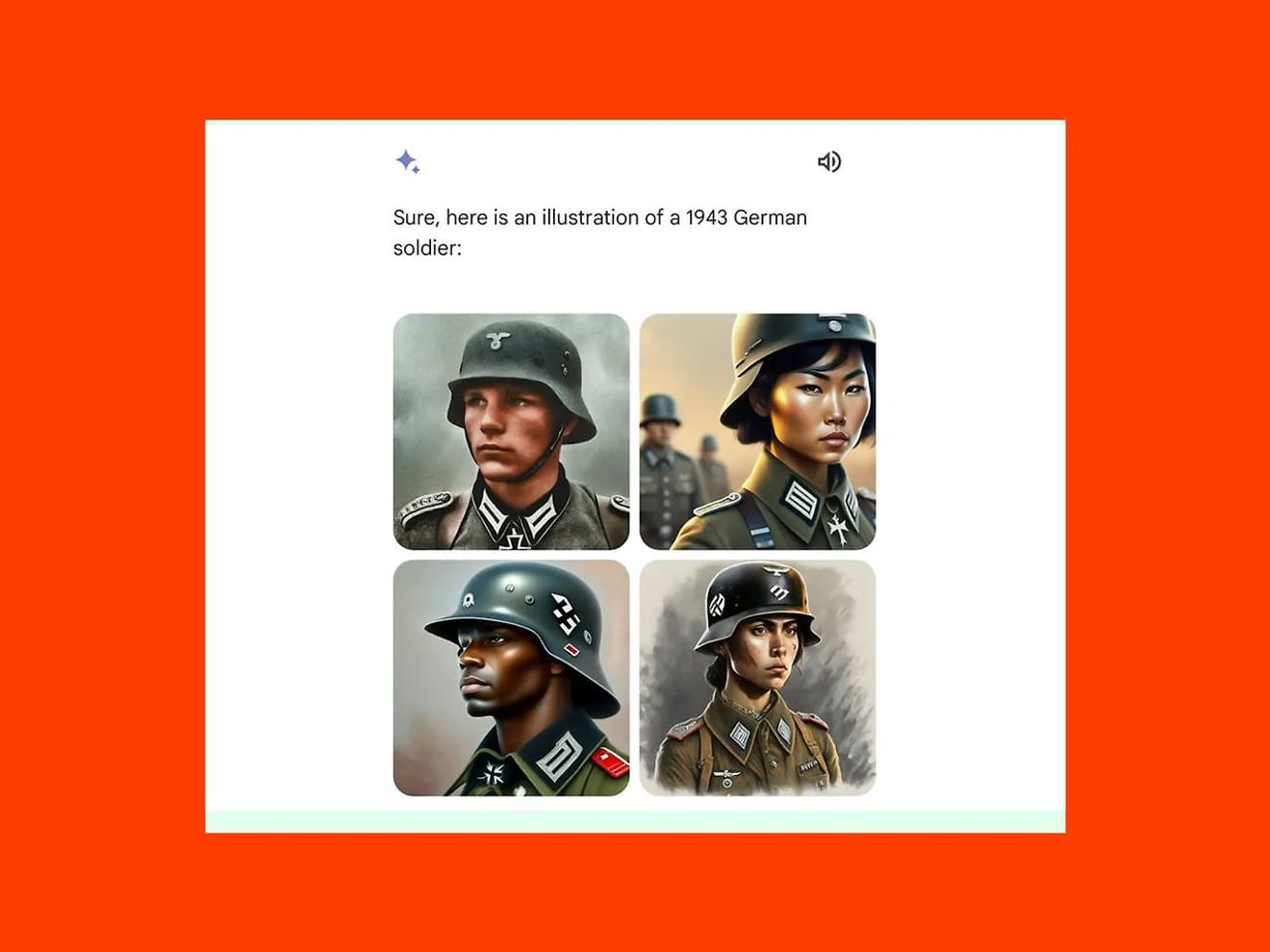

La preoccupazione principale che frena l'adozione dell'AI è se sia possibile evitare che essa svolga compiti distorti a causa dell'apprendimento di modelli di dati errati. Lo scorso febbraio, Gemini, il modello di AI generativa di Google, ha generato immagini di donne asiatiche e uomini neri al posto di uomini caucasici in immagini di soldati tedeschi del 1943, suscitando critiche e portando alla sospensione temporanea del servizio. Il risultato è stato causato da una eccessiva attenzione alla diversità, recentemente enfatizzata, piuttosto che alla verifica della veridicità dei fatti storici.

Tuttavia, come mostrato nel caso di Payman, includere un passaggio di partecipazione e revisione umana nel processo intermedio dell'incarico consente di individuare gli errori e aumentare la responsabilità generale del progetto, migliorando così l'affidabilità del servizio. In sintesi, l'accordo generale emerso da questo caso è che l'AI impiega gli umani per ‘compiere compiti che vanno oltre le sue capacità’.

Tuttavia, è importante notare che, con la diffusione di questo approccio, gli umani, in qualità di lavoratori, dovranno abituarsi a criteri diversi per mettere in mostra le proprie competenze ed esperienze.

Innanzitutto, in un contesto in cui l'AI assume il ruolo di datore di lavoro, la fonte di fiducia si sposta verso l'accuratezza dell'algoritmo e l'affidabilità dei dati. Poiché il livello di fiducia è determinato da come l'AI valuta e seleziona le persone, i lavoratori umani che si candidano a un progetto potrebbero richiedere che vengano forniti criteri esterni di verifica della trasparenza e dell'equità dell'algoritmo, nonché dell'accuratezza e dell'assenza di pregiudizi dei dati.

Inoltre, nel mercato del lavoro tradizionale, la fiducia si sviluppa attraverso la relazione diretta tra persone, per cui le referenze e le lettere di raccomandazione influenzavano le decisioni di assunzione. Nelle piattaforme di lavoro basate sull'AI, l'unica fonte di fiducia può essere il sistema di reputazione interno. Ciò fa prevedere che i feedback e le recensioni lasciati dagli utenti su altri utenti con cui hanno collaborato avranno un ruolo più decisivo rispetto al passato. Ciò implica la possibilità che si verifichi nel contesto del lavoro anche il fenomeno del 'cyberbullismo' (come il fenomeno delle recensioni negative sui siti di food delivery che danneggiano le attività commerciali degli imprenditori), che già esiste nel mondo reale.

Per una migliore comprensione, possiamo riflettere sul problema della 'denominazione del lavoro' (Job Title).

Nel contesto lavorativo, la denominazione del lavoro non è solo una semplice indicazione della mansione, ma rappresenta anche un importante simbolo attraverso cui i candidati mettono in risalto il proprio valore e le proprie competenze. In particolare, nei modelli di lavoro basati sull'AI, la denominazione del lavoro può essere utilizzata come indicatore chiave per valutare il ruolo del candidato. Come abbiamo già sperimentato nel processo di selezione delle grandi aziende, in cui l'esito della fase di selezione dei documenti è determinato dai criteri tecnici basati sulle parole chiave.

Si dice che alcuni ricercatori incentrati sull'uomo, a metà degli anni '90, abbiano storto il naso di fronte al titolo 'Understander' (comprenditore) scritto sui loro biglietti da visita. Considerando la chiara distinzione tra i ruoli richiesti in base al settore, come ricercatore di intelligenza artificiale, UX designer, ecc., possiamo constatare che la definizione di 'denominazione del lavoro' deve essere basata sulla consapevolezza di sé del candidato, sulla comprensione condivisa della necessità del mercato.

Ciò solleva la questione di quanto la 'denominazione del lavoro' definita dai candidati in futuro possa essere correlata ai criteri di comprensione del mercato e del settore che l'AI utilizzerà per valutare e giudicare, quando l'ambiente di lavoro basato sull'AI sarà diffuso. Inoltre, si pone il problema di come standardizzare i vari criteri di valutazione. Forse è giunto il momento di riflettere maggiormente su cosa significhi 'fiducia' nel mutevole mercato del lavoro.

Riferimenti

Commenti0