La ricerca pubblicata il 18 scorso da un team di ricercatori della Stanford University dimostra quanto siano profonde e potenzialmente pericolose le segretezze che circondano GPT-4 e altri sistemi di intelligenza artificiale all'avanguardia.

Presentazione dell'Indice di Trasparenza dei Modelli Fondamentali, Università di Stanford

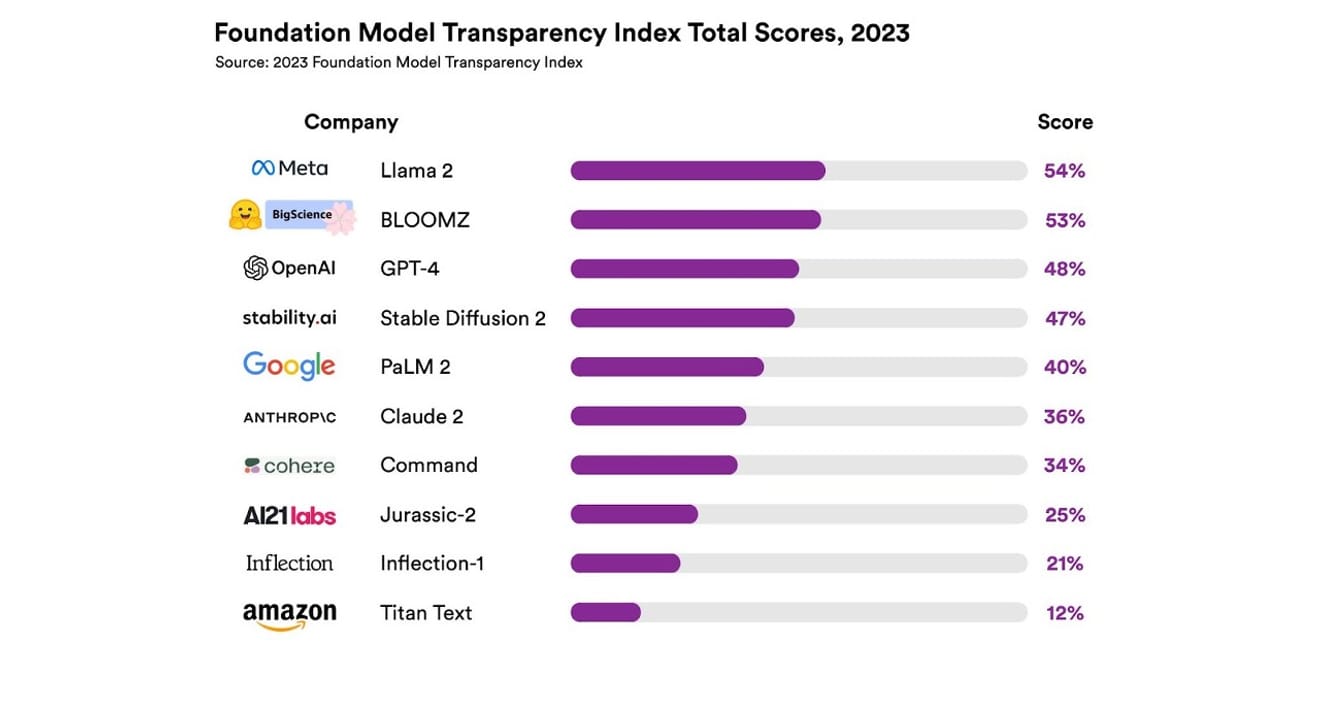

I ricercatori hanno analizzato un totale di 10 diversi sistemi di intelligenza artificiale, la maggior parte dei quali erano modelli linguistici di grandi dimensioni (LLM), simili a quelli utilizzati per ChatGPT e altri chatbot. Tra questi modelli vi erano quelli ampiamente utilizzati nel mercato commerciale, come GPT-4 di OpenAI, PaLM 2 di Google e Titan Text di Amazon. La trasparenza di questi modelli è stata valutata in base a 13 criteri, tra cui la trasparenza dei dati utilizzati per addestrare il modello (inclusi i metodi di raccolta e annotazione dei dati e l'inclusione di materiali coperti da copyright). Hanno anche studiato se i dati relativi all'hardware utilizzato per addestrare ed eseguire i modelli, ai framework software impiegati e al consumo energetico del progetto fossero resi pubblici.

Il risultato è stato che nessun modello di intelligenza artificiale ha superato il 54% della scala di trasparenza su tutti i criteri menzionati. Complessivamente, Titan Text di Amazon si è classificato come il modello meno trasparente, mentre Llama 2 di Meta è stato identificato come il più aperto. È interessante notare che Llama 2, uno dei principali modelli di contrasto tra modelli aperti e chiusi, pur essendo un modello open source, non ha divulgato i dati utilizzati per l'addestramento, i metodi di raccolta e di organizzazione dei dati, e così via. In altre parole, nonostante l'influenza crescente dell'intelligenza artificiale sulla nostra società, la mancanza di trasparenza nel settore è un fenomeno generale e persistente.

Questo significa che il settore dell'intelligenza artificiale rischia di diventare un'area incentrata sul profitto piuttosto che sul progresso scientifico, con la possibilità che conduca a un futuro dominato da un monopolio di alcune aziende specifiche.

Eric Lee/Bloomberg via Getty Images

Sam Altman, CEO di OpenAI, ha già incontrato i responsabili politici di tutto il mondo per spiegare loro questa nuova e sconosciuta intelligenza e offrire il proprio aiuto nella definizione di normative specifiche in materia. Pur sostenendo in linea di principio l'idea di un'organizzazione internazionale di supervisione dell'intelligenza artificiale, ritiene che alcune regole restrittive, come il divieto di tutti i materiali protetti da copyright nei set di dati, potrebbero rappresentare un ostacolo ingiusto. È evidente che il concetto di 'apertura' insito nel nome OpenAI si è allontanato dalla radicale trasparenza inizialmente proposta.

Tuttavia, è importante notare che i risultati del rapporto di Stanford suggeriscono che non è necessario mantenere i propri modelli così segreti per motivi di competizione. Infatti, i risultati sono un indicatore delle prestazioni scarse di quasi tutte le aziende. Ad esempio, afferma che nessuna azienda fornisce statistiche sul numero di utenti che si affidano ai propri modelli o sulle aree geografiche o di mercato in cui vengono utilizzati.

Nelle organizzazioni che adottano l'open source come principio, c'è un proverbio che recita: "Dove ci sono molti occhi, tutti i bug vengono scoperti". (Legge di Linus) Il numero grezzo aiuta a identificare e risolvere i problemi e a trovare problemi che possono essere risolti.

Tuttavia, le pratiche open source tendono gradualmente a far perdere alle aziende, sia interne che esterne, il riconoscimento sociale e il valore, quindi un'enfasi indiscriminata non ha molto senso. Pertanto, invece di concentrarsi sul quadro dei modelli aperti o chiusi, è meglio concentrarsi sul migliorare gradualmente l'accessibilità esterna dei "dati" che costituiscono la base dei modelli di intelligenza artificiale.

Per il progresso scientifico è importante garantire la riproducibilità (Reproducibility) di determinati risultati di ricerca. Se non si concretizzano soluzioni per garantire la trasparenza dei principali componenti di creazione di ciascun modello, è probabile che il settore rimanga bloccato in una situazione di monopolio chiusa e stagnante. E questo è un aspetto che deve essere considerato con priorità assoluta, soprattutto considerando la rapidità con cui l'intelligenza artificiale si sta diffondendo in tutti i settori, oggi e in futuro.

Per giornalisti e scienziati è diventato importante comprendere i dati, e per i responsabili politici la trasparenza è una precondizione per i futuri sforzi politici. Anche per il pubblico la trasparenza è importante, in quanto utenti finali dei sistemi di intelligenza artificiale, potendo essere autori o vittime di potenziali problemi legati alla proprietà intellettuale, al consumo energetico e ai pregiudizi. Sam Altman sostiene che il rischio di estinzione dell'umanità causato dall'intelligenza artificiale dovrebbe essere una priorità globale, come le pandemie o la guerra nucleare. Tuttavia, non dobbiamo dimenticare che, prima di raggiungere una situazione così pericolosa, la sopravvivenza della nostra società, che mantiene un rapporto sano con l'intelligenza artificiale in evoluzione, è fondamentale.

*Questo articolo è la versione originale del pezzo pubblicato sul quotidiano elettronico 'Electronic Newspaper' il 23 ottobre 2023.

References

Commenti0