Qualche tempo fa, a pochi mesi dal lancio di ChatGPT, si è verificato un dramma straordinario all'interno del consiglio di amministrazione di OpenAI, un'organizzazione no profit che in breve tempo è passata da zero a un fatturato annuo di 1 miliardo di dollari. Il CEO dell'azienda, Sam Altman, è stato licenziato e, dopo l'annuncio del suo passaggio a Microsoft, è stato reintegrato nel ruolo di CEO di OpenAI. In genere, il CEO fondatore è la figura più potente di un'azienda, quindi è raro che il consiglio di amministrazione lo licenzi, soprattutto se si tratta di un'azienda gigante dal valore di 80 miliardi di dollari.

Eppure, questo dramma intenso durato cinque giorni è stato possibile grazie alla particolare struttura di OpenAI, legata alla sua mission di 'servire l'umanità'. I tre membri indipendenti del consiglio di amministrazione, che si dice abbiano guidato la decisione di licenziare Altman, sono tutti legati all'altruismo efficace (EA, effective altruism), un concetto correlato alla mission aziendale e all'obiettivo di 'impedire che l'umanità e tutto ciò che è osservabile nell'universo scompaiano'.

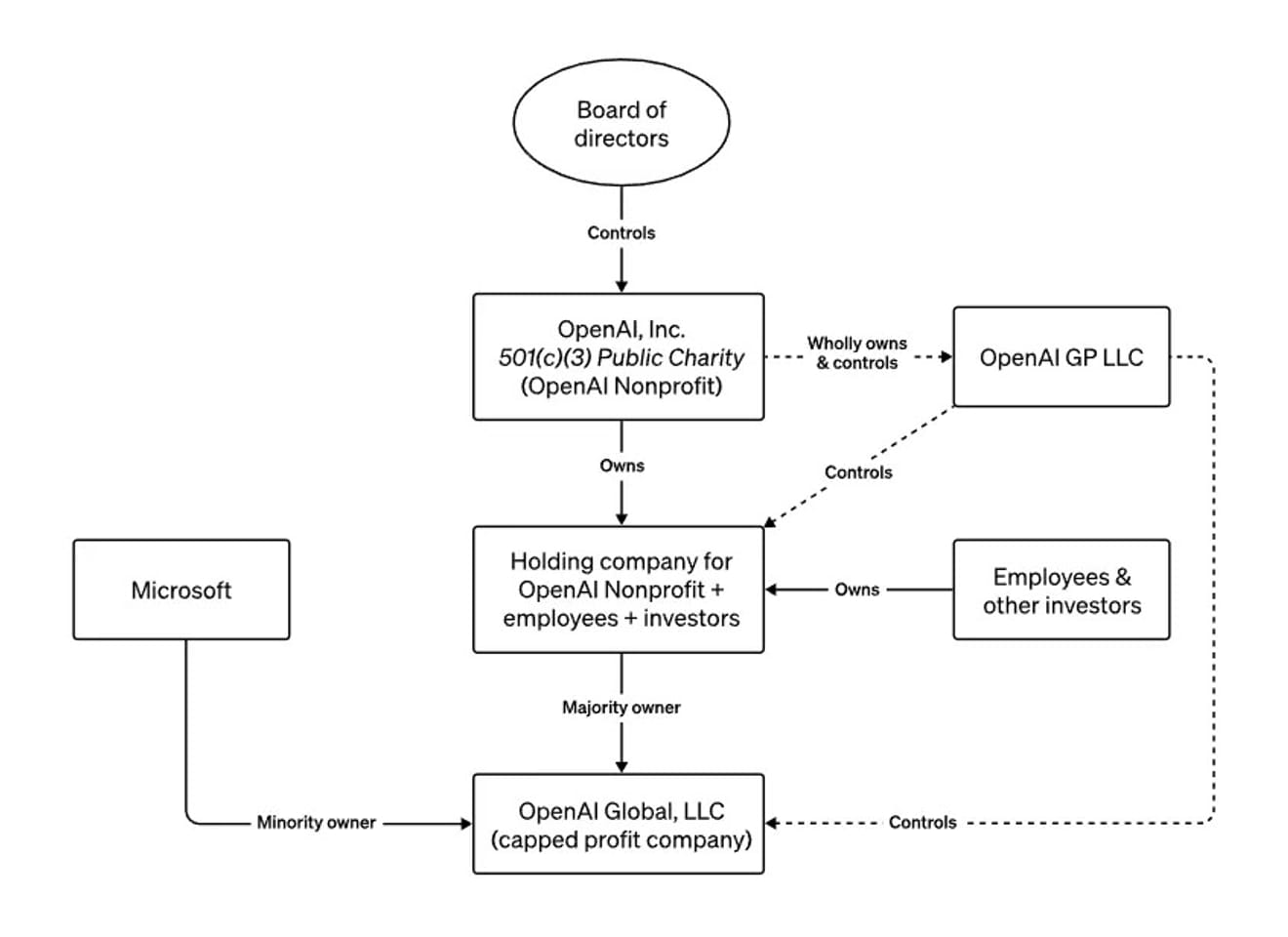

la struttura del consiglio di amministrazione di OpenAI

Nel corso dell'anno, durante i suoi viaggi in tutto il mondo, Altman ha avvertito i media e i governi sui rischi esistenziali della tecnologia che stava sviluppando, descrivendo la peculiare struttura di OpenAI, con la sua componente no profit e quella profit, come un campanello d'allarme contro lo sviluppo sconsiderato di un'intelligenza artificiale potente. In un'intervista a Bloomberg dello scorso giugno, ha anche affermato che, se avesse compiuto azioni pericolose o contrarie all'interesse dell'umanità, il consiglio di amministrazione avrebbe potuto licenziarlo. In altre parole, la struttura era stata intenzionalmente progettata in modo che un consiglio di amministrazione che desse priorità alla sicurezza rispetto al denaro, in relazione alla comparsa di un AGI incontrollabile, potesse licenziare il CEO in qualsiasi momento.

Come dovremmo quindi interpretare l'attuale situazione, in cui il nuovo CEO di OpenAI è lo stesso del precedente?

Non possiamo liquidare questa vicenda come un semplice contrattempo senza conseguenze, perché ci ha fatto capire che le decisioni relative allo sviluppo di un'intelligenza artificiale etica, che potrebbe avere il maggiore impatto sulla nostra società, sono state prese in base alle opinioni di un numero ristretto di persone. Sam Altman è ormai diventato un simbolo di un'epoca in cui lo sguardo di tutto il mondo è puntato sullo sviluppo e la regolamentazione dell'IA. Abbiamo assistito al processo di eliminazione di quello che era praticamente l'unico strumento esterno in grado di frenare le sue decisioni e valutazioni future, e di conseguenza abbiamo compreso l'importanza di ulteriori strumenti esterni.

Inoltre, questo evento ha contribuito a chiarire le posizioni e le interpretazioni dei catastrofisti che temono che l'IA possa distruggere l'umanità, dei transumanisti che credono che la tecnologia accelererà l'arrivo di un futuro utopico, dei sostenitori del libero mercato e del capitalismo sfrenato, e di coloro che sostengono una rigorosa regolamentazione delle grandi aziende tecnologiche per contenere i potenziali danni delle tecnologie dirompenti e il desiderio di lucro. E tutto ciò nasce dalla paura del futuro dell'umanità in un mondo in cui l'IA sarà parte integrante della nostra vita. Pertanto, è importante riconoscere la necessità di una maggiore diversità di comunità che ci aiutino a prevedere questo futuro.

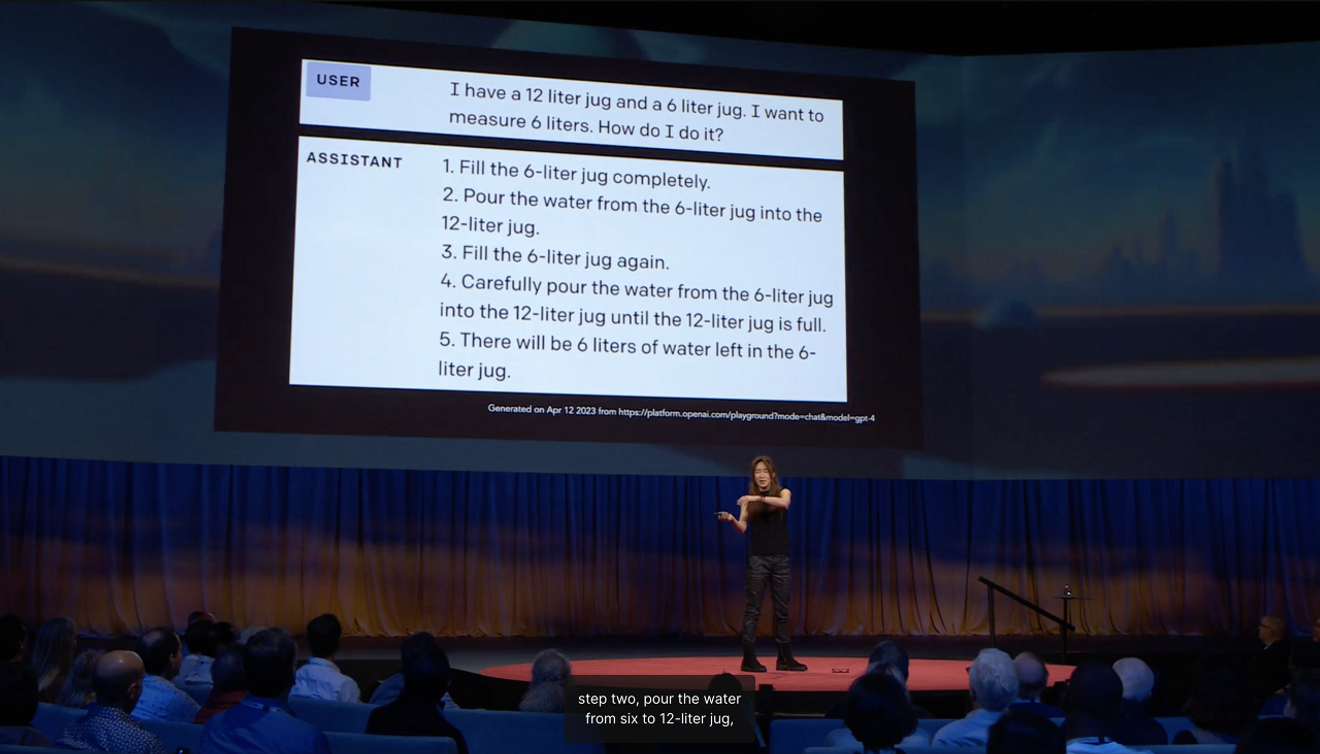

La professoressa Choi Ye-jin dell'Università di Washington, inclusa nella lista delle 100 persone più influenti al mondo nel campo dell'IA, ha spiegato nel suo discorso TED che il motivo per cui un'intelligenza artificiale in grado di superare gli esami di stato aggiunge in modo superfluo e stupido passaggi inutili nel calcolo della quantità di acqua (6 litri) utilizzando due bollitori da 12 e 6 litri è dovuto alla mancanza di apprendimento del senso comuneacquisito nella società.

Quando prevediamo il futuro, spesso identifichiamo qualcosa di nuovo da una prospettiva esterna, prendendo come riferimento i 'limiti' che indicano la direzione in cui si sta muovendo la corrente principale. In questo caso, ciò che dall'esterno appare come una visione stabile del futuro è sempre, in una certa misura, una aspettativa astratta derivata da esperienze concretebasate sul presente. L'antropologo americano Arjun Appadurai ha sostenuto che l'immaginazione non è una capacità privata e personale, ma una pratica sociale. Questo significa che diverse immaginazioni del futuro possono concretizzarsi, e possiamo interpretare questo evento come uno dei paesaggi creati dall'immaginazione di un futuro incerto legato alla comparsa di un AGI.

Avendo constatato che le aspettative dei leader del settore riguardo al futuro hanno un significato politicamente importante, in futuro sarà necessario approfondire la comprensione del futuro immaginato e costruito collettivamente in diversi contesti sociali e culturali, per decidere quale sarà il futuro dell'IA. È giunto il momento di chiederci come sia possibile creare opportunità per presentare attivamente le aspettative collettive basate sulle esperienze concrete all'interno di una più ampia varietà di comunità.

Riferimenti

Commenti0