新しいタイプの求人市場が登場しています。

数週間前、Payman AIは、まだクローズドベータテスト中ですが、人間に報酬を支払うAIサービス(AI that Pays Humans)を公開しました。このサービスは、依頼者がPaymanのAIエージェントの口座に支払いを済ませると、AIにアクセス権限を与え、現実世界で人間にしかできない作業を実行できるようになると説明しています。

例として示されている「顧客管理業務における10件のレビュー収集」プロジェクトでは、AIが依頼者が求めるレビューの最低限の構成要素を具体化・整理してプラットフォーム内で共有し、この依頼に関心を示した人々が実際に世に出てレビューを収集・提出、AIがその妥当性を判断し、各人に割り当てられた費用を支払う流れを示しています。

このようなやり方は、まだ単純なAIの適用事例に見えるかもしれません。しかし、少なくともAI導入において最も一般的で、簡単に解決できないボトルネックである「信頼」の領域に手がかりを提供するという点で、注目に値します。

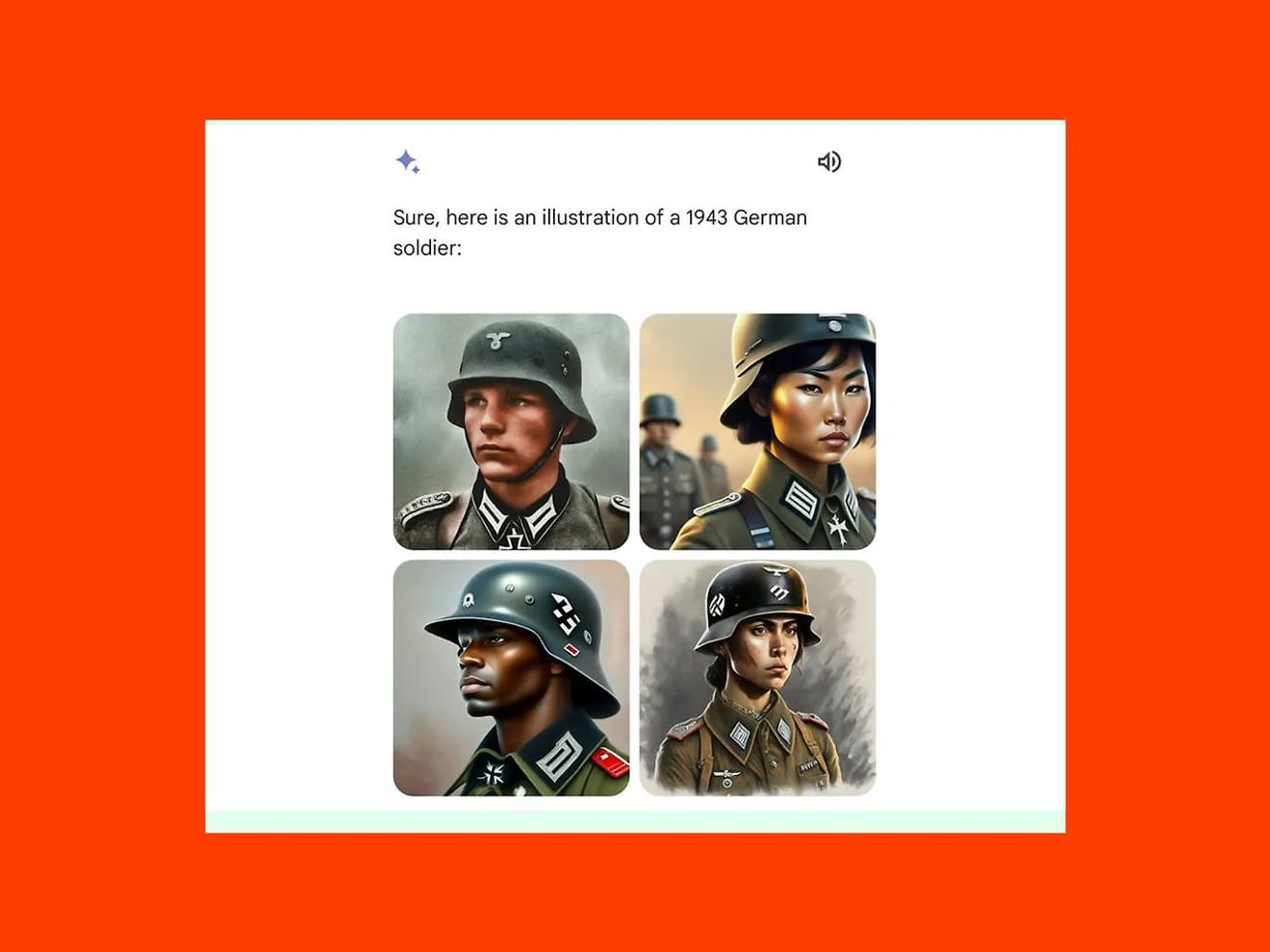

誤ったデータパターンを学習して偏った作業を実行してしまう状況を防ぐことができるのかという疑問は、AI導入に対する代表的な懸念です。今年2月、Googleの生成AIモデルであるGeminiは、1943年のドイツ軍の画像に白人男性の代わりに東洋人女性や黒人男性の画像を作成し、批判を受け、サービスを一時停止しました。歴史的事実の確認よりも、近年強調されている多様性への過度な集中が招いた結果です。

しかし、Paymanが示した事例のように、依頼に関わる中間プロセスに人が参加・確認する段階を含めることで、ミスを捕捉し、プロジェクト全体の責任感を高め、当該サービスに対する信頼性を向上させることができます。まとめると、この事例で確認される一般的な合意は、AIが人間を雇用することで「AIの能力を超えた作業を完了できる」ということです。

ただし、このようなアプローチが普及するにつれて、人間は労働者として自分の能力と経験をアピールするための、従来とは異なる基準に慣れていく必要がある点にも注意が必要です。

まず、AIが雇用者の役割を担う状況では、信頼の源泉はアルゴリズムの正確性とデータの信頼性に移動します。AIがどのように人を評価し、選抜するかによって信頼のレベルが決まるため、労働者としてプロジェクトに応募する人間は、関連するアルゴリズムが透明かつ公正であるか、データが正確で偏見がないかについて、外部から確認できる基準を示すことを求めるようになる可能性があります。

また、従来の雇用市場では、人同士の直接的な関係の中で信頼が形成されるため、口コミや推薦状などが雇用決定に影響を与えていましたが、AIベースの雇用プラットフォームでは、内部の評判システムだけが信頼の源泉となります。これは、ユーザーが協力などを通じてつながった他のユーザーに対して残すフィードバックやレビューが、これまで以上に決定的な役割を果たすようになることを予測させます。デリバリーサービスなどで、現実世界の自営業者が深刻な被害を受けるような「口コミテロ」が、雇用環境でも起こる可能性が高くなることを意味します。

より明確な理解のために、Job Title(職種)について考えてみましょう。

雇用環境において、Job Titleは単に職務を表すだけでなく、応募者が自分の価値と能力をアピールする重要な象徴でもあります。特にAIベースの雇用モデルでは、Job Titleは応募者の役割を判断する重要な指標として活用される可能性があります。私たちがすでに大企業の採用過程で、書類選考の合否判定がキーワード中心のスキル基準であることを経験しているように。

90年代半ば、人間中心の研究者の中には、自分の名刺に書かれたUnderstanderという肩書きに首を傾げた人もいたそうです。現在のAIリサーチャー、UXデザイナーなど、業界によって求められる役割が明確に区別されていることを考えると、応募者自身がどの分野でどのような役割を果たしてきたかを判断する際に、自己認識と市場のニーズに対する共通認識に基づいてJob Titleの定義が行われる必要があることが分かります。

これは、AIベースの雇用環境が到来したとき、将来の人間が応募者として定義した自分のJob Titleが、AIが判断し評価する市場や業界の理解基準とどれほど結びつくことができるのか、関連する様々な判断基準をどのように普遍化できるのかという疑問を生み出します。もしかしたら、今こそ変化する雇用市場において、「信頼」とは何かについて、より深く考える必要がある時期なのかもしれません。

参考文献

コメント0