Niedawno, zaledwie kilka miesięcy po premierze ChatGPT, w zarządzie OpenAI, non-profitowej organizacji, która w tak krótkim czasie osiągnęła roczne przychody w wysokości 1 miliarda dolarów, rozegrał się niezwykły dramat. Dyrektor generalny firmy, Sam Altman, został zwolniony, a po ogłoszeniu jego przejścia do Microsoftu, ostatecznie powrócił na stanowisko CEO OpenAI. Zazwyczaj założyciele firm są najsilniejszą siłą napędową, dlatego rzadko zdarza się, aby rada nadzorcza zwalniała takiego CEO, a co dopiero w przypadku gigantycznej firmy o wartości 80 miliardów dolarów.

Mimo to, ten pięciodniowy dramat mógł się rozegrać ze względu na unikalną strukturę OpenAI, związaną z misją „dla dobra ludzkości”. Trzech niezależnych członków rady nadzorczej, którzy rzekomo odegrali kluczową rolę w decyzji o zwolnieniu Altmana, jest powiązanych z efektywnym altruizmem (EA, effective altruism), ideą ściśle związaną z misją firmy – „zapobieganie zagładzie ludzkości i całego obserwowalnego wszechświata”.

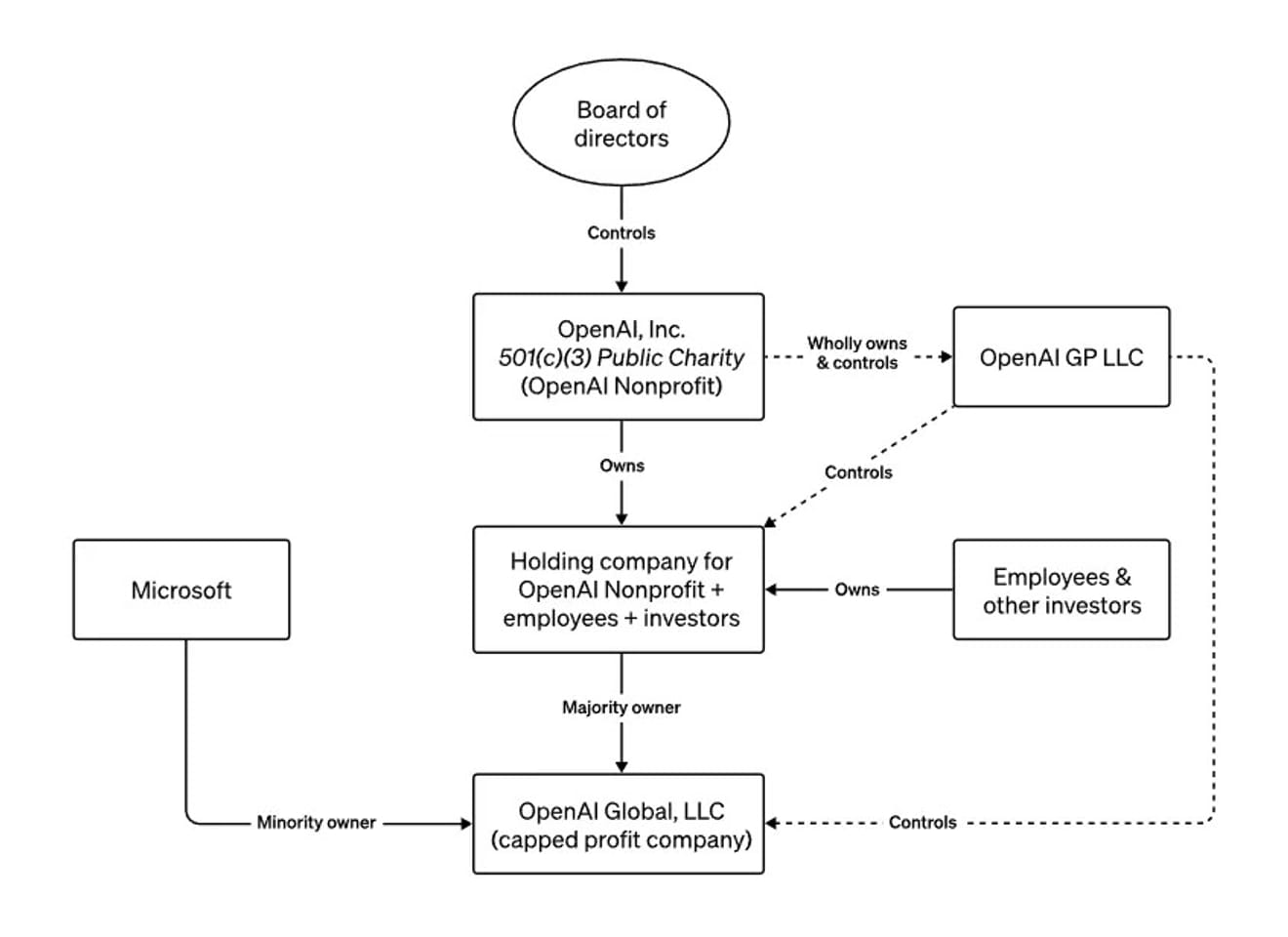

struktura zarządu OpenAI

Przez cały rok, podróżując po świecie i ostrzegając media oraz rządy przed egzystencjalnym zagrożeniem związanym z rozwijanymi przez niego technologiami, Altman przedstawiał unikalną strukturę OpenAI, łączącą organizację non-profit z elementem komercyjnym, jako ostrzeżenie przed nieodpowiedzialnym rozwojem silnej sztucznej inteligencji. W wywiadzie dla Bloomberga w czerwcu wspomniał, że rada nadzorcza ma możliwość usunięcia go ze stanowiska, gdyby podejmował działania niebezpieczne lub sprzeczne z interesami ludzkości. Innymi słowy, struktura została celowo zaprojektowana tak, aby rada nadzorcza, która priorytetowo traktuje bezpieczeństwo w kontekście pojawienia się niekontrolowanej AGI (sztucznej inteligencji ogólnej), a nie zyski, mogła w każdej chwili odwołać CEO.

Jak więc powinniśmy interpretować obecną sytuację, w której nowy CEO OpenAI jest identyczny z poprzednim?

Nie można sprowadzić tej sytuacji do bezsensownego incydentu, który nie przyniósł żadnych zmian. Kluczowe jest bowiem to, że ujawnił on fakt, iż decyzje dotyczące rozwoju etycznej sztucznej inteligencji, która może mieć największy wpływ na nasze społeczeństwo, podejmowane są w oparciu o opinie bardzo wąskiego grona osób. Sam Altman stał się symbolem ery, w której cały świat skupia uwagę na rozwoju i regulacji sztucznej inteligencji. Widzieliśmy, że jedyny zewnętrzny mechanizm, który mógłby ograniczyć jego decyzje i działania, został w zasadzie zlikwidowany, co podkreśla wagę poszukiwania dodatkowych zewnętrznych mechanizmów kontroli w przyszłości.

Ponadto, wydarzenia te ujawniły jasność poglądów zwolenników różnych perspektyw: pesymistów obawiających się, że AI doprowadzi do zagłady ludzkości, transhumanistów wierzących, że technologia przyspieszy nadejście utopijnej przyszłości, zwolenników wolnorynkowego kapitalizmu oraz tych, którzy opowiadają się za surowymi regulacjami dużych korporacji technologicznych, wierząc, że nie są w stanie utrzymać równowagi między potencjalnymi zagrożeniami płynącymi z potężnych, rewolucyjnych technologii a chęcią zarabiania pieniędzy. Wszystkie te perspektywy łączy jednak strach przed przyszłością z AI, co podkreśla potrzebę tworzenia bardziej zróżnicowanych społeczności, które będą w stanie prognozować tę przyszłość.

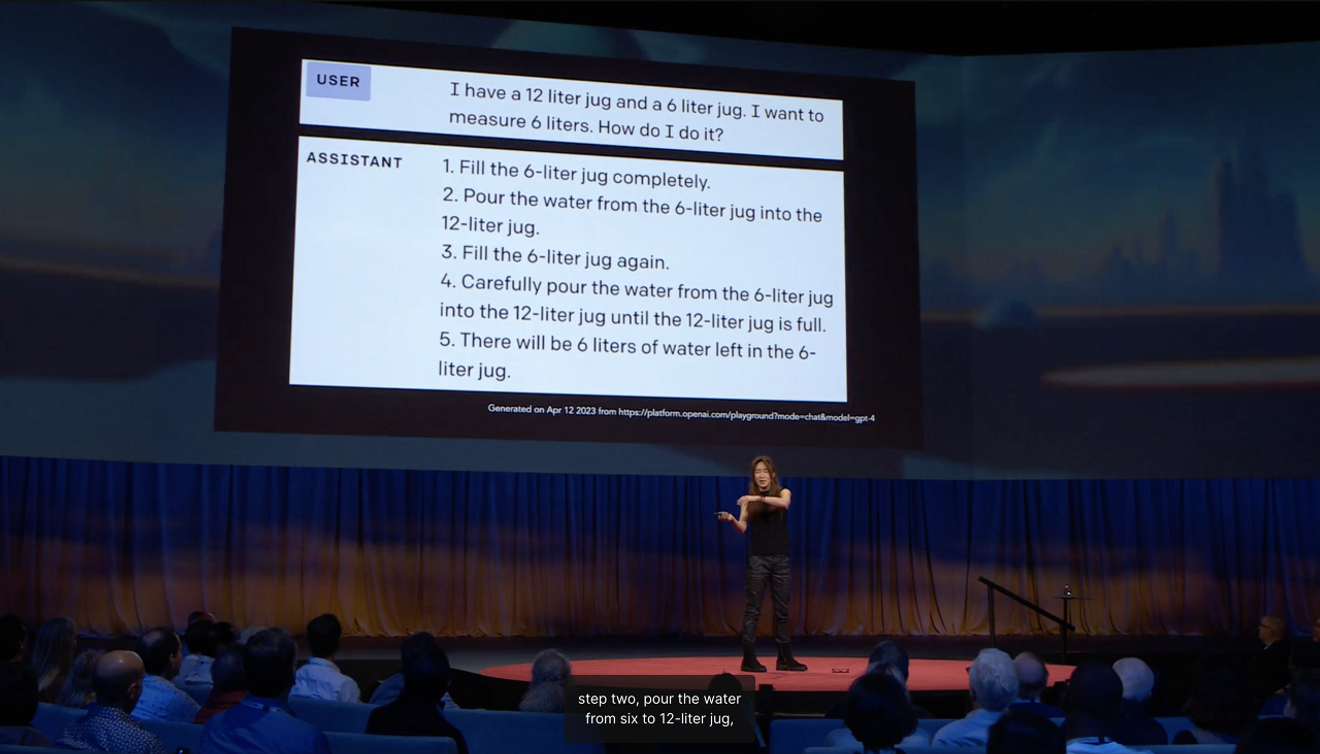

Choi Ye-jin, profesor Uniwersytetu Waszyngtońskiego, która znalazła się w gronie 100 najbardziej wpływowych osób na świecie w dziedzinie sztucznej inteligencji, w swoim wystąpieniu TED wyjaśniła, że powodem, dla którego sztuczna inteligencja, zdolna do zdania egzaminów państwowych, w tak głupi sposób dodaje zbędne kroki do zadania polegającego na pomiarze 6 litrów wody za pomocą dzbanków o pojemności 12 i 6 litrów, jest braki w nauce zdrowego rozsądkuw procesie socjalizacji.

Próbując przewidywać przyszłość, często identyfikujemy nowości z perspektywy outsidera, biorąc pod uwagę „granice”, które wskazują kierunek dominujących trendów. W takim przypadku to, co z zewnątrz wydaje się stabilną wizją przyszłości, zawsze w pewnym stopniu opiera się na obecnej rzeczywistości, na abstrakcyjnych oczekiwaniach wywiedzionych z „żywych doświadczeń”. Amerykański antropolog Arjun Appadurai argumentował, że wyobraźnia nie jest prywatną i indywidualną zdolnością, ale społecznym działaniem. Oznacza to, że różne wizje przyszłości mogą stać się rzeczywistością, a obecna sytuacja może być interpretowana jako jeden z krajobrazów wykreowanych przez wyobraźnię związaną z niepewną przyszłością pojawienia się AGI.

Skoro oczekiwania liderów branży dotyczące przyszłości mają tak duże znaczenie polityczne, w przyszłości będziemy musieli pogłębić zrozumienie przyszłości tworzonej i wyobrażanej zbiorowo w różnych kontekstach społecznych i kulturowych, podczas podejmowania decyzji dotyczących rozwoju AI. Należy zadać pytanie, jak stworzyć możliwości aktywnego prezentowania zbiorowych oczekiwań opartych na żywych doświadczeniach w różnych społecznościach.

Literatura

Komentarze0