Há algum tempo, após alguns meses do lançamento do ChatGPT, um drama imenso se desenrolou no conselho de administração da OpenAI, uma organização sem fins lucrativos que passou do zero a US$ 1 bilhão em receita anual. O CEO da empresa, Sam Altman, foi demitido e, após o anúncio de sua transferência para a Microsoft, sua volta ao cargo de CEO da OpenAI foi decidida. Normalmente, o CEO fundador é a força mais poderosa da empresa, por isso é raro o conselho demiti-lo, e, principalmente, se a empresa tiver um valor de mercado de US$ 80 bilhões, ninguém se atreveria a mexer nela.

No entanto, essa intensa saga de cinco dias foi possível devido à estrutura singular da OpenAI, vinculada à sua missão declarada de 'servir à humanidade'. Os três membros independentes do conselho de administração, que teriam liderado a decisão de demitir Altman, de acordo com relatos, estão todos relacionados ao altruísmo eficaz (EA, effective altruism) e sua ligação com a missão da empresa, com o objetivo de 'garantir que a humanidade e tudo no universo observável não desapareçam'.

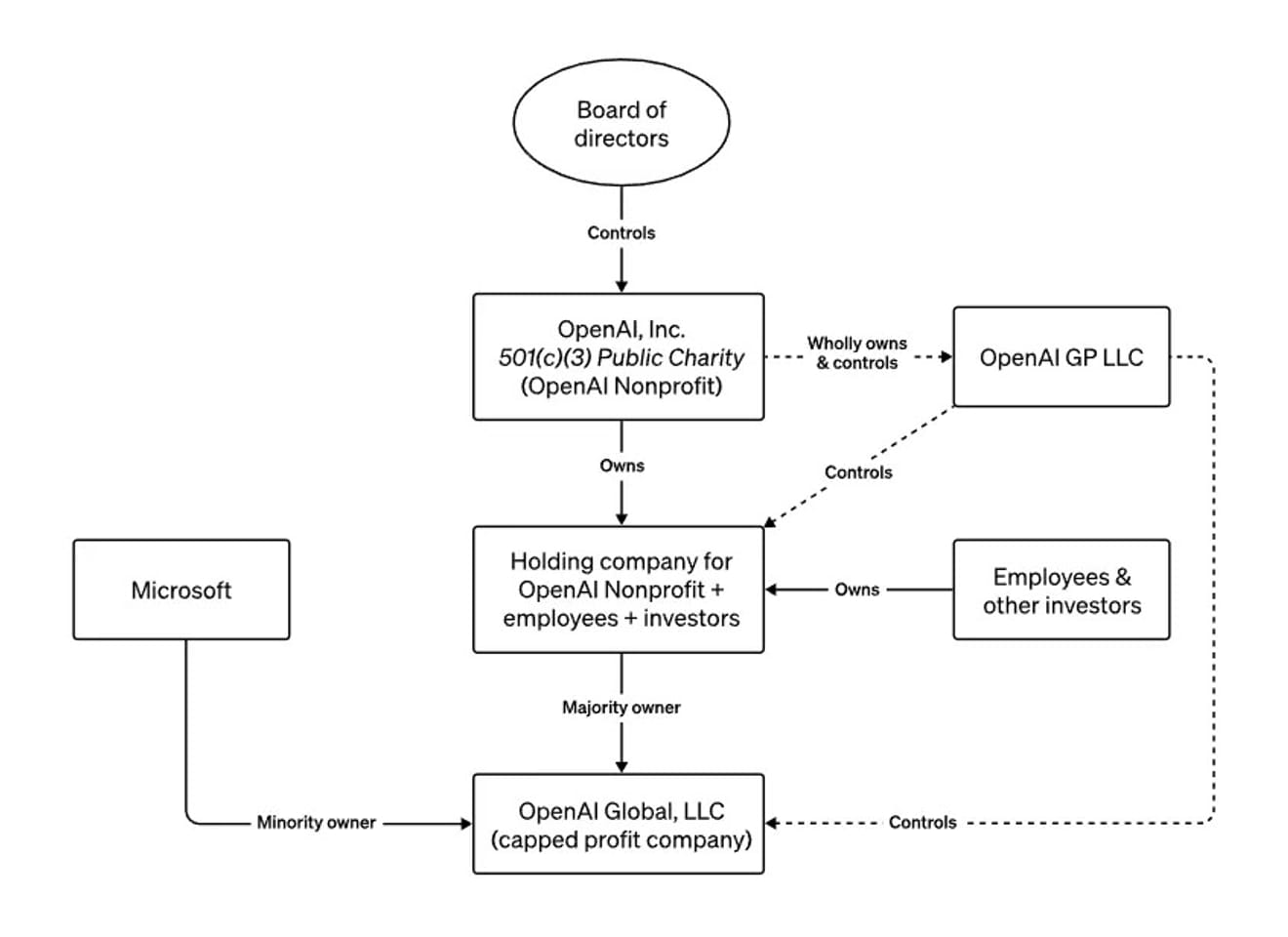

a estrutura do conselho da OpenAI

Ao percorrer o mundo todo neste ano, alertando a mídia e governos sobre os riscos existenciais da tecnologia que estava desenvolvendo, Altman descreveu a peculiar estrutura de OpenAI, com uma organização sem fins lucrativos dentro de uma organização com fins lucrativos, como um alerta contra o desenvolvimento irresponsável de IAs poderosas. Ele também mencionou em uma entrevista à Bloomberg em junho que, caso ele tomasse ações perigosas ou que fossem contrárias aos interesses da humanidade, o conselho poderia demiti-lo. Em outras palavras, a estrutura foi propositalmente projetada para permitir que o conselho, que priorizava a segurança em relação a uma IAG incontrolável, demitisse o CEO a qualquer momento.

Então, como devemos interpretar a situação atual, em que o novo CEO da OpenAI é o mesmo do anterior?

Não é possível concluir que tudo se resolveu em um evento sem consequências, pois o episódio revelou que decisões relacionadas ao desenvolvimento ético da inteligência artificial, que pode ter o maior impacto na nossa sociedade, foram tomadas com base nas opiniões de um grupo extremamente restrito de pessoas. Sam Altman tornou-se um símbolo da era em que a atenção do mundo se volta para o desenvolvimento e regulamentação da IA. Vimos o processo de descarte do que era praticamente o único meio externo de impedir suas decisões e julgamentos, e com isso percebemos a importância de mecanismos externos adicionais no futuro.

Além disso, este incidente tornou mais claras as posições e interpretações de quem teme que a IA destrua a humanidade (catastrofistas), de quem acredita que a tecnologia acelerará um futuro utópico (transumanistas), de quem confia no livre mercado capitalista, e de quem defende regulamentações rigorosas para conter as grandes empresas de tecnologia, acreditando que elas não conseguem equilibrar o potencial de danos de tecnologias poderosas e destrutivas com a ganância por lucro. E, o que é notável, é que todas essas perspectivas partem do medo do futuro da humanidade em conjunto com a IA, o que indica a necessidade de uma gama maior de comunidades para prever esse futuro.

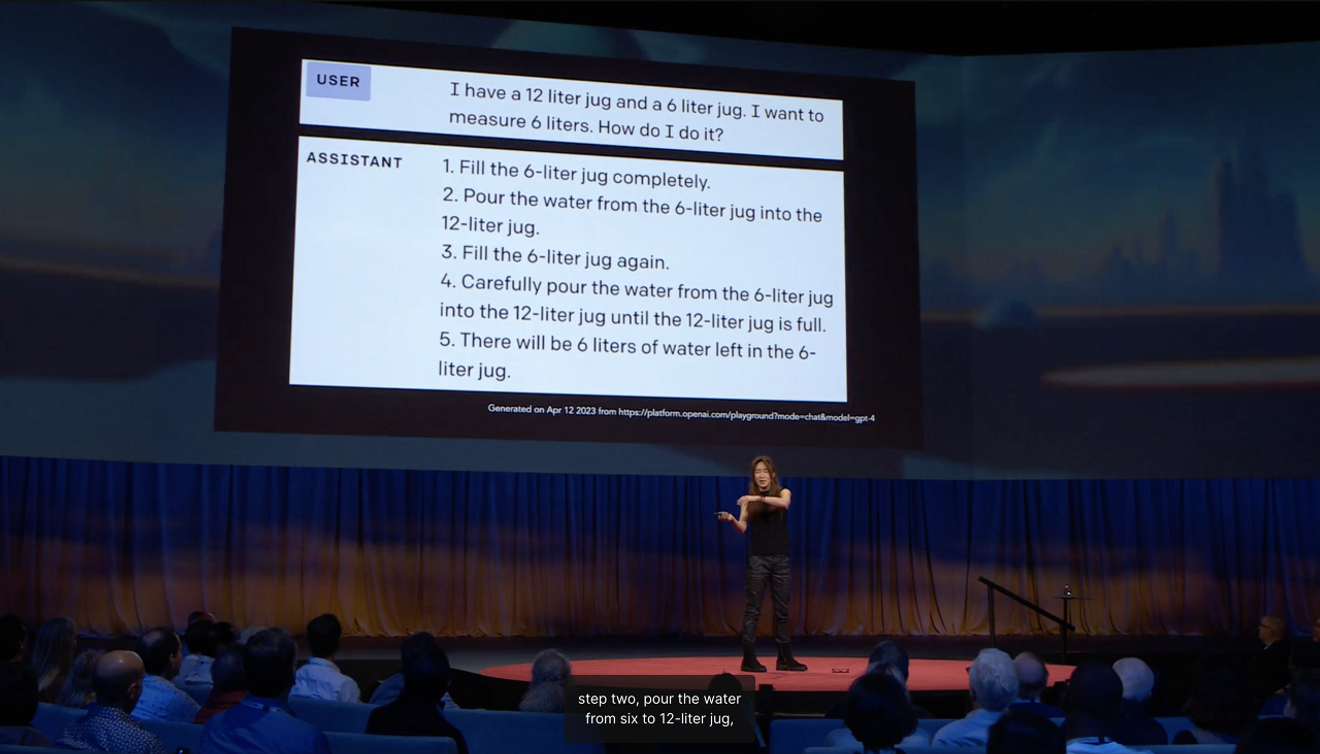

Choi Ye-jin, professora da Universidade de Washington, incluída na lista das 100 pessoas mais influentes do mundo na área de IA, explicou em sua palestra TED que a razão pela qual uma IA capaz de passar em vários exames de admissão ao serviço público adiciona etapas desnecessárias e bobas ao medir a quantidade de 6 litros de água usando jarros de 12 e 6 litros é devido àfalta de aprendizado de senso comumadquirido na sociedade.

Ao prever o futuro, costumamos identificar algo novo de uma perspectiva externa, usando como referência os 'limites' que indicam para onde a corrente principal está se dirigindo. Nesse contexto, o que parece ser uma visão estável do futuro, proveniente de fora, sempre se baseia em alguma medida naexpectativa abstrata derivada de 'experiências vívidas'com base no presente. O antropólogo americano Arjun Appadurai argumentou que a imaginação não é uma capacidade privada e individual, mas sim uma prática social. Isso significa que a imaginação de vários futuros pode se tornar realidade, e podemos interpretar este incidente como uma das paisagens criadas pela imaginação de um futuro incerto relacionado ao surgimento da IAG.

Tendo em vista que as expectativas dos líderes do setor em relação ao futuro têm um significado politicamente importante, no futuro precisaremos de uma compreensão mais profunda do futuro imaginado e construído coletivamente em diversos contextos sociais e culturais para decidir o futuro da IA. É hora de questionar como podemos criar oportunidades para que as expectativas coletivas, baseadas em experiências vívidas dentro de diversas comunidades, sejam apresentadas ativamente.

Referências

Comentários0