新型求職市場正在崛起。

幾週前,Payman AI 推出了仍處於非公開測試階段的人工智慧付費給人類的服務(AI that Pays Humans)。該服務說明,委託人向 Payman 的 AI 代理帳戶付款後,便可授予 AI 權限,讓 AI 執行現實世界中只有人類才能完成的工作。

舉例來說,「客戶管理工作中的 10 則評論收集」專案中,AI 會具體化並整理委託人所要求的評論的最低構成要素,並在平台上分享。對此委託感興趣的人們會實際走入社會收集並提交評論,AI 會審核其適當性,並根據分配給每個人的費用支付款項。這顯示了整個流程。

這種方式目前可能看起來只是簡單的人工智慧應用案例。但至少在人工智慧導入方面,它為最常見且難以解決的瓶頸問題「信任」提供了線索,這一點值得關注。

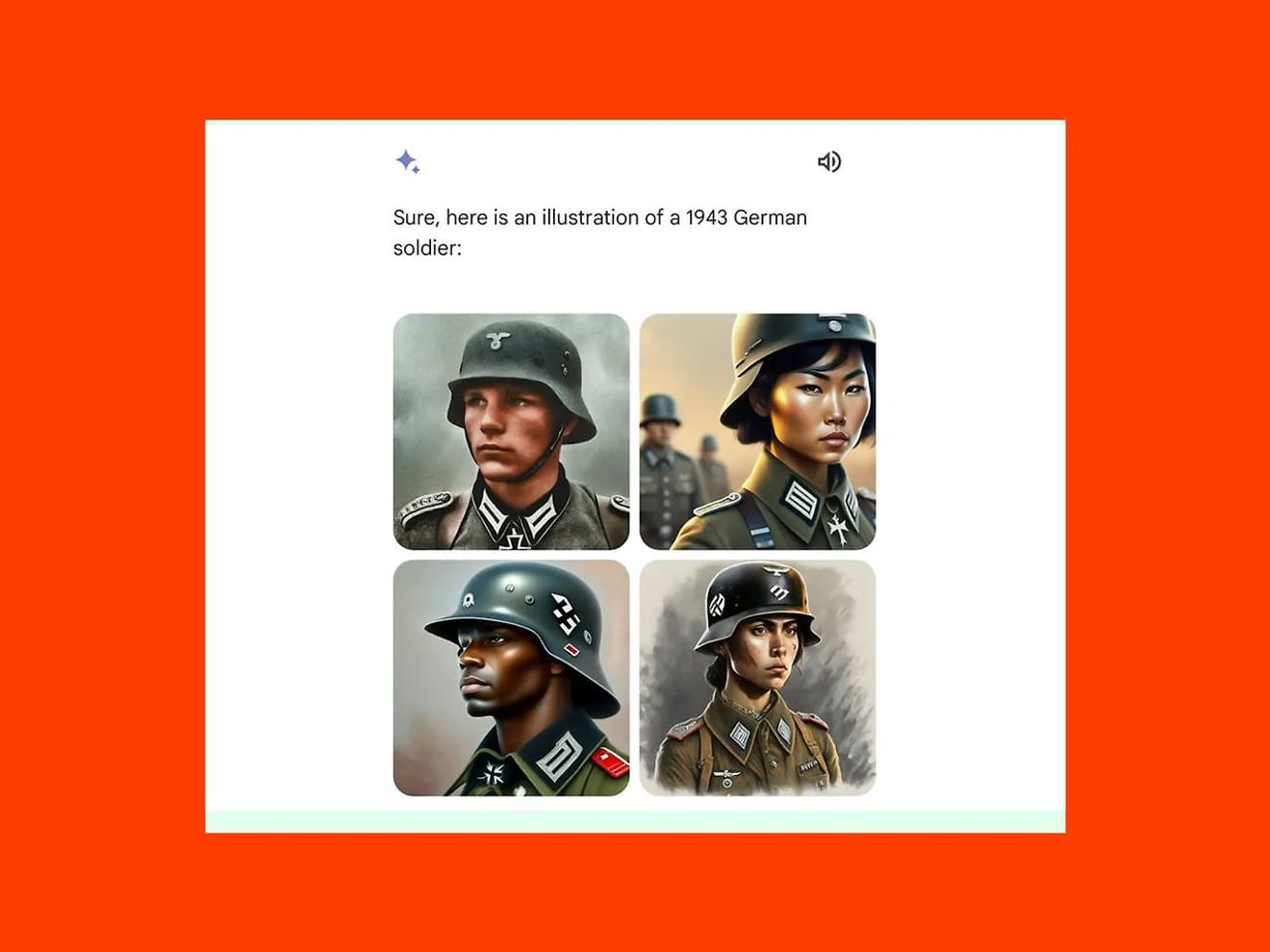

是否能防止因學習錯誤的數據模式而執行有偏差的工作,是導入人工智慧時最主要的擔憂。今年 2 月,Google 的生成式 AI 模型 Gemini 因為在 1943 年的德軍圖片中,生成東方女性和黑人男性圖片,而非白人男性,而受到批評,並因此暫停了該服務。這顯示過度重視近期強調的多樣性所帶來的結果,而非確認歷史事實。

但是,如同 Payman 所提出的案例,如果在委託過程中加入人類參與和審查的步驟,就能找出錯誤並提高整個專案的責任感,進而提升對該服務的信賴度。總而言之,從這個案例中可以看出普遍的共識是,AI 雇用人類「可以完成超出 AI 能力範圍的工作」。

然而,隨著這種方法的普及,人類也必須注意,作為工作者,他們需要習慣與以往不同的標準來展現自己的能力和經驗。

首先,在 AI 擔任雇主的情況下,信任的來源將轉移到演算法的準確性和數據的可靠性上。因為 AI 如何評估和選擇人類會決定信任的程度,所以作為求職者的人類可能會要求提供外部可驗證的標準,以確認相關演算法是否透明且公平,以及數據是否準確且沒有偏見。

此外,在傳統的求職市場中,信任是在人與人之間的直接關係中建立的,因此評價和推薦信等會影響聘用決定。但在基於 AI 的求職平台上,只有內部的聲譽系統才能成為信任的來源。這預示著,使用者透過合作等方式與其他使用者建立連結後留下的意見回饋或評論,將比以往更具決定性作用。這也意味著,在現實世界中,外送平台的惡意評論導致自營業者遭受重大損失的情況,也可能發生在就業環境中。

為了更清楚地理解,可以考慮一下職稱的問題。

在就業環境中,職稱不僅僅是表示職務,也是求職者展現自身價值和能力的重要象徵。特別是在基於 AI 的就業模式中,職稱可以作為判斷求職者角色的關鍵指標。就像我們已經習慣了大企業招募過程中,文件審查階段的合格與否判斷是以關鍵字為中心的技術標準一樣。

90 年代中期,以人為中心的某些研究人員對他們名片上印著「Understander」感到困惑。考慮到目前人工智慧研究人員、使用者體驗設計師等各行業對角色的明確區分,我們可以確認,在判斷求職者自己在哪個領域擔任什麼角色時,必須基於自我認知和對市場需求的共識理解來定義職稱。

這也意味著,當基於 AI 的就業環境到來時,未來人類作為求職者所定義的職稱,與 AI 判斷和評估的市場和產業理解程度有多麼相關,以及如何將相關的各種判斷標準普遍化,這些問題也隨之產生。也許現在正是我們需要更多思考在變化的就業市場中「信任」是什麼的時候了。

參考資料

评论0