18日にスタンフォード大学の研究チームが発表した研究は、GPT-4やその他の最先端のAIシステムの秘密がどれほど深く、潜在的に危険なものになり得るかを示している。

スタンフォード大学、ファウンデーションモデル透明性指標の紹介 (Introducing The Foundation Model Transparency Index, Stanford University)

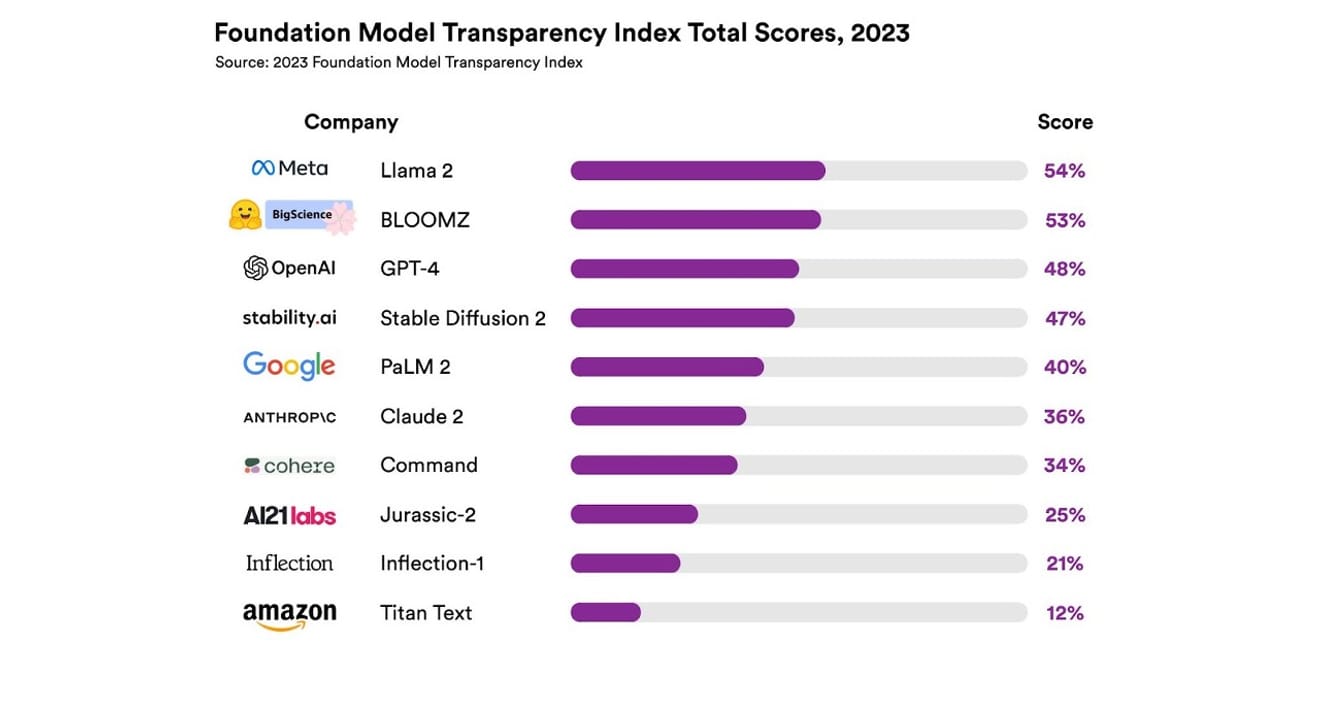

彼らは、合計10種類の異なるAIシステムを調査した。そのほとんどは、ChatGPTやその他のチャットボットで使用されているものと同じ大規模言語モデルだった。これには、OpenAIのGPT-4、GoogleのPaLM 2、AmazonのTitan Textなど、広く使用されている商用モデルが含まれており、開発者がモデルの学習に使用したデータについてどれほど透明性を保っているか(データの収集とアノテーションの方法、著作権のある資料の包含の有無など)を含む13の基準に基づいて、オープン性を評価した。また、モデルの訓練と実行に使用されたハードウェア、使用されたソフトウェアフレームワーク、プロジェクトのエネルギー消費量に関する開示についても調査した。

その結果、すべての基準にわたって透明性尺度で54%以上を達成したAIモデルはなかったということだった。全体として、AmazonのTitan Textが最も透明性が低いと評価され、MetaのLlama 2が最もオープンであると選定された。興味深いのは、最近注目を集めているオープン型とクローズド型のモデルの対立構造の代表格であるLlama 2が、オープンソースモデルであるにもかかわらず、学習に使用されたデータ、データの収集とキュレーションの方法などを公開していないということだ。つまり、AIが社会に与える影響が大きくなっているにもかかわらず、業界の関連する不透明性は、全体的かつ継続的に確認される現象だということだ。

これは、まもなくAI業界が科学的な進歩ではなく収益中心の分野になるリスクがあり、特定の企業が主導する独占的な未来につながる可能性もあることを意味する。

Eric Lee/Bloomberg via Getty Images

すでにOpenAIのCEOであるサム・アルトマンは、世界中の政策立案者と会い、彼らにこの新しく見慣れない知性について積極的に説明し、関連する規制の具体化を支援する意思を公然と表明してきた。しかし、彼は原則としてAIを監督する国際機関のアイデアを支持する一方で、データセットから著作権のあるすべての資料を禁止するなど、一部の限定的な規則は不公平な障害になる可能性があると考えることもある。OpenAIという社名に込められた「オープン性」が、設立当初に提示された急進的な透明性から変化したことは明らかだ。

しかし、今回のスタンフォードのレポートの結果が示すように、競争のためにそれぞれが自分のモデルをそれほど秘密にする必要はないという点にも注目する必要がある。この結果は、ほぼすべての企業が不振を示す指標でもあるからだ。例えば、どのくらいのユーザーが自社のモデルに依存しているか、自社のモデルを使用している地域または市場セグメントに関する統計を提供している企業はないという。

オープンソースを原則とする組織の間では、「目が多いとすべてのバグは明らかになる」(ライナス・ロウ)という諺がある。原始的な数は、問題を解決し、修正できる問題を発見するのに役立つ。

しかし、オープンソースの慣行は、徐々に公開企業の内外における社会的ステータスと価値の承認を失わせる傾向もあるため、無条件に強調することは大きな意味がない。そのため、モデルがオープン型かクローズド型かという枠にとらわれるのではなく、強力なAIモデルの基礎となる「データ」への外部アクセスを徐々に広げることに議論の焦点を当てる方が良い選択になる可能性がある。

科学の発展には、特定の研究結果が再現されるかどうかを確認する再現性(Reproducibility)の確保が重要だ。これにより、各モデル生成の主要な構成要素に向けた透明性が保証される方法を具体化しないと、最終的に業界は閉鎖的で停滞した独占的な状況にとどまる可能性が高い。そして、これは、産業全体にAI技術が急速に浸透しつつある現在と将来の状況において、かなり重要な優先事項として考慮されるべきであることを覚えておく必要がある。

ジャーナリストや科学者にとって、データの理解が重要になり、政策立案者にとって透明性は予定されている政策的努力の前提条件だ。一般の人々にとっても、透明性は、AIシステムの最終的なユーザーとして、知的財産権、エネルギー消費量、偏見に関連する潜在的な問題の加害者または被害者になる可能性があるため重要だ。サム・アルトマンは、AIによる人類滅亡のリスクは、伝染病や核戦争などの社会的規模のリスクの一つとして、世界的な優先事項となるべきだと主張する。しかし、彼が言及した危険な状況に達するまでには、進化していくAIと健全な関係を維持する私たちの社会の存続がその前提であることを忘れてはならない。

*この記事は、23年10月23日付の電子新聞の署名コラムに掲載された内容の原文です。

References

コメント0