Eine kürzlich von Forschern der Stanford University veröffentlichte Studie zeigt, wie tiefgründig und potenziell gefährlich die Geheimnisse von GPT-4 und anderen hochmodernen KI-Systemen sind.

Einführung des Foundation Model Transparency Index, Stanford University

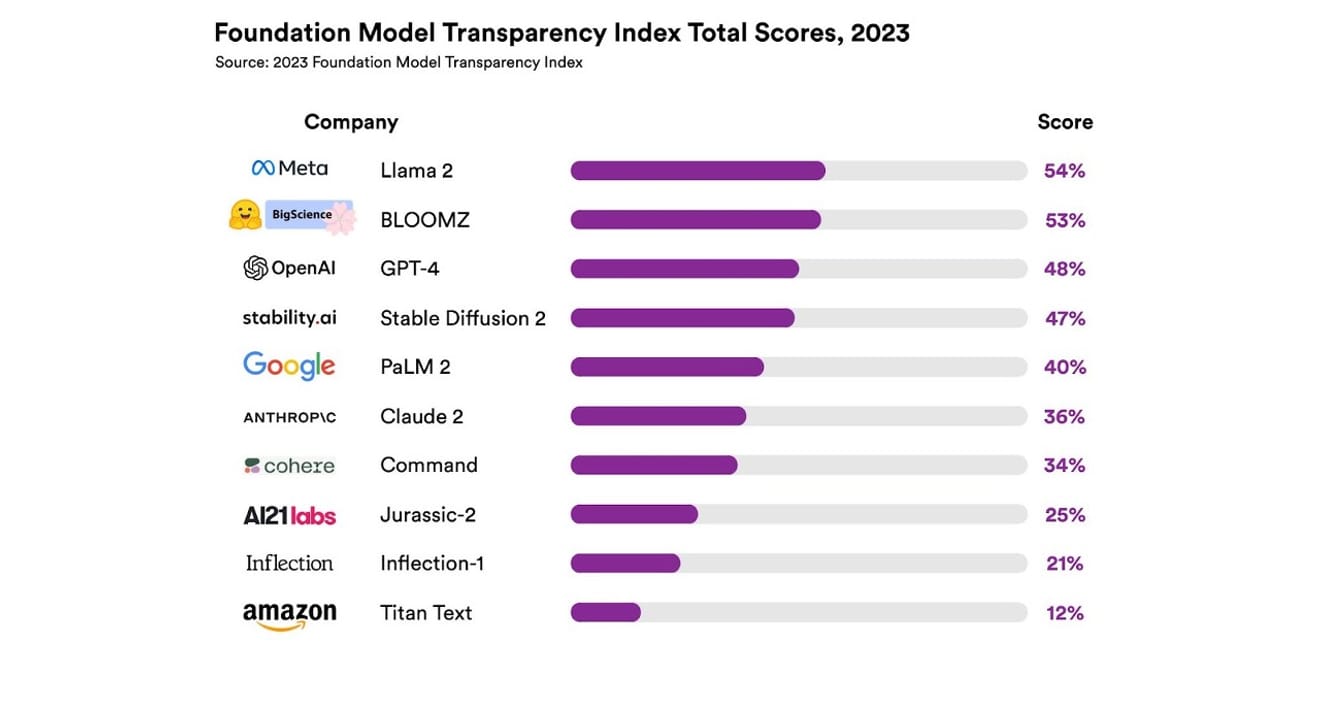

Insgesamt wurden 10 verschiedene KI-Systeme untersucht, die meisten davon große Sprachmodelle (LLMs), wie sie auch in ChatGPT und anderen Chatbots verwendet werden. Dazu gehören weit verbreitete kommerzielle Modelle wie GPT-4 von OpenAI, PaLM 2 von Google und Titan Text von Amazon. Die Offenheit der Modelle wurde anhand von 13 Kriterien bewertet, darunter die Transparenz der Entwickler in Bezug auf die Daten, die zum Trainieren des Modells verwendet wurden (einschließlich der Methoden zur Datenerhebung und -annotation sowie der Einbeziehung urheberrechtlich geschützter Materialien). Außerdem wurde untersucht, ob Informationen über die Hardware und die Software-Frameworks, die zum Trainieren und Betreiben des Modells verwendet wurden, sowie über den Energieverbrauch des Projekts öffentlich zugänglich gemacht wurden.

Das Ergebnis war, dass kein KI-Modell in Bezug auf die Transparenz mehr als 54 % der Kriterien erfüllte. Insgesamt wurde Titan Text von Amazon als am wenigsten transparent eingestuft, während Llama 2 von Meta als am offensten eingestuft wurde. Interessanterweise wurde Llama 2, der prominente Vertreter der jüngsten Kontroverse um Open-Source- und Closed-Source-Modelle, trotz seines Open-Source-Charakters nicht transparent in Bezug auf die verwendeten Daten, die Methoden der Datenerhebung und -aufbereitung usw. Dies zeigt, dass die zunehmende gesellschaftliche Bedeutung von KI mit einer anhaltenden und weit verbreiteten Intransparenz in der Branche einhergeht.

Dies bedeutet, dass die KI-Branche Gefahr läuft, sich eher zu einem gewinnorientierten Bereich als zu einem Bereich wissenschaftlicher Fortschritte zu entwickeln, was möglicherweise zu einer von bestimmten Unternehmen dominierten, monopolistischen Zukunft führt..

Eric Lee/Bloomberg via Getty Images

Sam Altman, CEO von OpenAI, hat bereits mit politischen Entscheidungsträgern weltweit gesprochen und sich öffentlich dafür eingesetzt, ihnen diese ungewohnte und neue Intelligenz näherzubringen und die Entwicklung konkreter Regulierungen zu unterstützen. Er unterstützt zwar prinzipiell die Idee einer internationalen Organisation zur Überwachung von KI, glaubt aber auch, dass einige restriktive Regeln, wie z. B. das Verbot aller urheberrechtlich geschützten Materialien aus Datensätzen, unfaire Hindernisse darstellen könnten. Dies zeigt deutlich, dass sich die ‚Offenheit‘, die im Namen von OpenAI zum Ausdruck kommt, von der radikalen Transparenz, die ursprünglich angestrebt wurde, entfernt hat.

Allerdings ist es auch wichtig zu beachten, dass die Ergebnisse des Stanford-Berichts zeigen, dass es keinen zwingenden Grund gibt, die eigenen Modelle aus Wettbewerbsgründen so geheim zu halten. Denn die Ergebnisse zeigen auch, dass fast alle Unternehmen in dieser Hinsicht schlecht abschneiden. Zum Beispiel gibt es laut Bericht kein Unternehmen, das Statistiken darüber liefert, wie viele Benutzer auf sein Modell zugreifen oder in welchen Regionen bzw. Marktsegmenten das Modell verwendet wird.

In Open-Source-Organisationen gibt es das Sprichwort ‚Viele Augen entdecken alle Fehler‘ (Linus's Law). Die schiere Anzahl der Beteiligten hilft dabei, Probleme zu lösen und zu beheben.

Allerdings führt die Praxis von Open Source auch dazu, dass der soziale Status und die Wertschätzung sowohl innerhalb als auch außerhalb von Unternehmen, die Transparenz praktizieren, allmählich abnehmen. Daher ist eine unbedingte Betonung nicht sinnvoll. Anstatt sich auf die Frage zu konzentrieren, ob ein Modell Open Source oder Closed Source ist, sollte der Fokus eher darauf liegen, den externen Zugriff auf die ‚Daten‘, die die Grundlage für KI-Modelle bilden, schrittweise zu erweitern. Dies wäre die bessere Herangehensweise.

Für den wissenschaftlichen Fortschritt ist es wichtig, die Reproduzierbarkeit (Reproducibility) bestimmter Forschungsergebnisse sicherzustellen. Ohne die Konkretisierung von Maßnahmen zur Gewährleistung von Transparenz in Bezug auf die wichtigsten Bestandteile der Modellgenerierung wird die Branche wahrscheinlich in einem geschlossenen und stagnierenden Monopol gefangen bleiben. Angesichts der rasanten Verbreitung von KI-Technologien in allen Industriezweigen ist dies ein wichtiger Aspekt, der Priorität haben sollte.

Für Journalisten und Wissenschaftler ist es wichtiger denn je, Daten zu verstehen, und für politische Entscheidungsträger ist Transparenz eine Voraussetzung für geplante politische Maßnahmen. Auch für die breite Öffentlichkeit ist Transparenz wichtig, da sie als Endnutzer von KI-Systemen zu potentiellen Tätern oder Opfern von Problemen im Zusammenhang mit geistigem Eigentum, Energieverbrauch oder Voreingenommenheit werden kann. Sam Altman argumentiert, dass das Risiko einer durch KI verursachten Auslöschung zu den gesellschaftlichen Risiken gehört, die mit globaler Priorität behandelt werden sollten, wie z. B. Pandemien oder Atomkriege. Doch bevor ein derartiges katastrophales Szenario eintreten kann, muss man sicherstellen, dass unsere Gesellschaft in einer dauerhaften, gesunden Beziehung zu der sich entwickelnden KI steht.

*Dieser Artikel ist die Originalfassung eines Artikels, der am 23. Oktober 2023 in der elektronischen Zeitung ‚Electronic Newspaper‘ veröffentlicht wurde.

Referenzen

Kommentare0